人工智能在听起来像人方面已经好得惊人

合成声音已经变得无处不在。它们早上为我们提供方向指引,白天引导我们完成电话通话,晚上在智能扬声器上播放新闻。而且随着用于制造它们的技术的进步,这些声音变得越来越像人声。这是合成语音的最后前沿:不仅复制我们所说的内容,而且复制我们说话的方式。

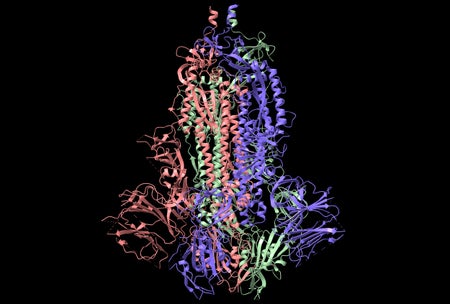

Rupal Patel 领导着东北大学的一个研究小组,研究语音韵律——我们用来通过声音传达意图和情感的音高、响度和持续时间的变化。“有时人们认为它像是锦上添花,”她解释说。“你有了信息,现在是如何调节该信息,但我真的认为它是赋予信息本身意义的支架。”

Patel 说,她对韵律产生兴趣是在发现它是语音交流中唯一似乎可供某些严重言语障碍患者使用的元素之后。这些患者即使不能清晰说话,也能够发出富有表现力的声音。2014 年,Patel 创立了一家公司,为不会说话的个人构建定制的合成声音。VocaliD 此后已扩展到商业品牌和影响者。

多年来,合成语音已经取得了长足的进步。Siri 九岁了,是最老的虚拟助手——但在会说话的机器世界里,她还是个婴儿。人们至少从 18 世纪就开始尝试合成语音,当时一位奥匈帝国发明家建造了一个粗糙的人类声道复制品,它可以表达完整的短语(尽管是单调的)。

当前的机器学习技术可以模拟人类语音,包括尴尬的停顿和咂嘴声。尽管如此,对于大多数现实世界的系统来说,每秒数千个样本的训练成本仍然过高。包括 VocaliD 的研究人员在内的研究人员正在不断实施更新、更有效的方法。

但即使人类语音和合成语音之间剩余的差距正在稳步缩小,真正逼真的韵律仍然让最复杂的系统难以捉摸。也许仍然缺少的东西要求机器不仅要模仿人类,还要像我们一样感受。