本文发表于《大众科学》的前博客网络,反映了作者的观点,不一定反映《大众科学》的观点

作为一家应用计算机视觉公司的首席技术官,我大部分时间都在监督和完善全栈人工智能设置,这些设置采用神经网络和计算机视觉算法来识别和分析图像和图片的内容。在业余时间,我与我的爵士五重奏乐队一起演奏萨克斯,与其他音乐家轮流独奏、即兴演奏和自由发挥。这是一个充满情感、惊喜和交流的过程。我一直认为这是一项独特的人类事业——一项不受技术篡夺野心影响的事业。

的确,很长一段时间以来,我只从人工智能的实用优势来看待它的可行性。最近涌现出大量关于神经网络和创造力的实验——从写诗和设计世纪中期家具到生成刻意非衍生的绘画和创造时装秀时尚——开始改变我的看法。这让我开始思考,同样的方法是否可以应用于爵士乐——以及最终目的是什么?创建一个能够通过爵士图灵测试的人工智能机器人、程序或代理有什么好处?以今天的人工智能技术水平,这甚至是可以想象的吗?我研究了这个课题,并与来自学术界和商界的、处于人工智能和音乐交叉领域的专家,以及我的一些音乐家同行进行了交谈。以下是我的发现。

有些音乐类型比其他类型更适合人工智能

关于支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。 通过购买订阅,您将帮助确保有关塑造我们今天世界的发现和想法的具有影响力的故事的未来。

在人工智能和音乐创作的交叉领域,已经做了很多工作。科技巨头如微软、谷歌、IBM Watson和索尼,以及初创公司如Aiva和Amper,都拥有商业上可用的技术和围绕人工智能生成音乐的业务。去年夏天,YouTube 明星泰琳·南方发布了我是人工智能专辑,该专辑是在 Aiva、Amper、微软和 IBM 的工具和技术的帮助下创作的。您在商店、电梯、电视购物广告和视频游戏中听到的一些配乐很可能是人工智能创作的。有些是由管弦乐队根据人工智能创作的乐谱和编曲进行现场演奏的。有些是流行音乐的录音棚制作风格,以超乎寻常的完美形式直接从计算机中喷涌而出。

尽管有一些人为干预的例外情况,但您可能在那些场所和平台上听不到人工智能生成的爵士乐。这有点令人惊讶,因为算法有时会产生意想不到的结果,这似乎很适合爵士乐的即兴性质。然而,正如任何专业的爵士音乐家或俱乐部老板可以证明的那样,爵士乐往往是表演者爱的劳动。它服务于热情的利基受众。而且,人们很难期望它能像自动配乐 YouTube 内容和视频游戏那样引起商业上的紧迫性。

但还有其他挑战。

你的学习有多深入?

DeepJazz 是普林斯顿大学计算机科学系学生金智星在 2016 年的一个项目,它吐出了帕特·梅西尼的《然后我知道了》的钢琴独奏变奏曲。该模型使用帕特·梅西尼原曲 MIDI 文件作为数据源,Keras 和 Theano 机器学习 API,以及一个

长短期记忆(LTSM)循环神经网络。循环神经网络(RNN)在今天的人工智能作曲中很流行,因为它们通过循环从先前的输入中学习,从而动态地进行反向传播。

也就是说,传统的 RNN 往往只适用于简短的乐句。如果您创作的音乐长度超过铃声,那么 LTSM 就会发挥作用,因为它们能够调用更多的内存,并在整首歌曲的过程中工作,处理整体结构、副歌、桥段、叠句等等。

如果对节奏和力度进行更多细微的调整,那么 DeepJazz 产生的广阔旋律和跳跃的和弦进行肯定可以被认为是真品,如果您在收音机、超市或客户服务等待时听到它们。但是,如果作为计算机或人类图灵测试问题提出——即这首歌是由人还是机器创作的?——可能就没那么容易了。由于它只在一首歌曲上进行了训练,DeepJazz 的输出永远只能产生听起来类似于那首歌曲的结果。

更重要的是,输出将原始的吉他、贝斯、鼓和键盘乐器缩减为仅钢琴。从原始歌曲及其原始乐器生成即兴演奏将是一项更加复杂的任务。毕竟,钢琴的固定音符与通常与爵士乐相关的其他乐器(如小号、长号和萨克斯管)的可塑性更强的扩展音调之间存在很大差异。

卡内基梅隆大学计算机科学教授罗杰·丹能伯格说:“对于计算机来说,使管乐器如此困难的事情是,您一直在向它们注入能量,因此您可以进行持续控制,而爵士乐演奏者可以自由地非常有表现力地使用这种控制。”他本人也演奏爵士小号。“这不仅仅是弄清楚要演奏哪些音符,而是如何演奏它们。您几乎可以无限灵活地控制颤音、弯音,甚至产生钢琴等乐器根本无法发出的声音。”

现场援助

除了音色之外,与人工智能“音乐家”的现场表演还带来了其他挑战。无论音乐类型如何,现场即兴演奏的集体即兴演奏期间音乐家之间发生的临时、实时的交流在机器和人类之间仍然不存在。房间或表演场地的影响声音的声学效果、观众的能量,当然还有音乐家之间共享的视觉线索,都是当前任何技术都无法考虑的。

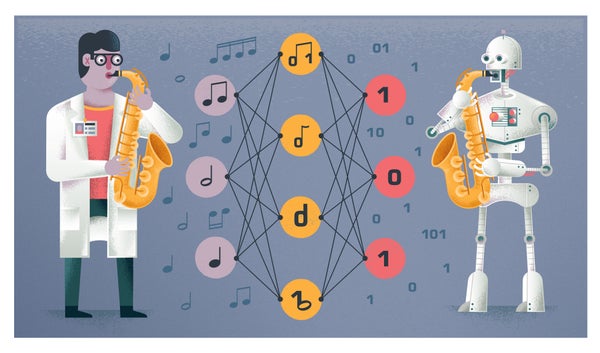

图片来源:埃里克·奈夫勒

这将需要复杂的音频识别技术,使机器能够听到和解释其他乐器,先进的计算机视觉技术来捕捉各种微妙的视觉线索,以及某种方式来向人类音乐家发出信号并与之交流——所有这些都与实时即兴算法同步。仅支持这些操作所需的计算能力就将是惊人的。许多研究——从机器人马林巴琴到任天堂 Wii 激活的波普爵士即兴演奏生成器到

现有的音乐软件混搭能够与人类音乐家进行机器人式的呼叫应答独奏——已经在这个领域完成,但还没有任何东西能够将通用或通用人工智能等同于有价值的人类爵士音乐家。

如果没有摇摆感,一切都毫无意义

鉴于一些关于使用神经网络在现有杰作上训练的艺术的研究和实验,我经常想知道是否可以用传奇爵士音乐家的音乐来实现同样的目标。是否有可能重现查理·帕克超快速的精湛波普爵士乐独奏,或康特·贝西钢琴和乐队的极简主义精确性?

查理·帕克确实演奏了音符,所以他的一些曲调已经被转录成乐谱和 MIDI,甚至有一些被输入到深度学习算法中。但这仍然不足以提供足够的训练数据,以机器演奏的方式输出新的查理·帕克独奏,从而具有引人入胜的效果并且能够通过图灵测试。尽管存在一些工具可以解析歌曲中的各个乐器音轨,但它们还不够好,无法解开现场表演的录音,而现场表演构成了一位伟大的爵士音乐家作品的很大一部分。

丹能伯格说:“那是另一个大型信号处理和机器学习问题,这是一个非常活跃的研究领域,但它尚未得到解决。” 这甚至还没有考虑到每场现场表演和录音所独有的节奏、音色、力度、张力、释放、戏剧性和叙事性的细微之处。

您可能需要从头开始创建自己的数据集:让新的爵士音乐家以每一种可能的查理·帕克或康特·贝西式的方式演奏每种乐器,然后在这些录音上训练算法。这种方法类似于 Amper Music 为其他音乐类型所做的事情。获取帕克或贝西本人的定制样本为时已晚,但对于约书亚·雷德曼或卡马西·华盛顿来说并非如此。将其视为音频的动作捕捉。

我们需要人工智能爵士乐吗?

目前,使用人工智能和爵士乐的最有希望的研究之一是在国防高级研究计划局 (DARPA) 进行的研究,该机构正在开发爵士演奏机器人,以研究和推进人与机器之间的交流,这在舞台上或在自主汽车合并而拥堵的高速公路出口处,以及在战场上都将同样有用。就人工智能生成的音乐而言,这似乎仍然更适合于更基于乐谱的音乐类型,如电影和古典音乐,或者高度制作且经常合成和大量采样的流行音乐。

我也对人工智能和爵士乐感到好奇,仅仅是因为有一天如果能拥有一个随时随地以无缝逼真的方式与你即兴演奏的音乐伙伴,那将很有用,不仅是为了纯粹的享受,也是为了学习。毕竟,如果音乐专业的学生拥有可以随时提供演奏指导和反馈的人工智能教师,他们的才能会有多大的提升?这将是对音乐教育的福音,并使练习更加实用。

我们离这两个目标都还很遥远。我们仍然不知道如何让这些爵士人工智能音乐家能够演奏或检测到“摇摆感”、“情感”和“灵魂”的存在。更重要的是,他们能即兴演奏吗——在传统的训练和音乐理论会让他们转弯的时候,他们却反其道而行之?正如我乐队的鼓手所说:“如果你谈论的是现场即兴演奏,那就会涉及到人工智能的终极核心。那就像拥有一段关系。它必须是 100% 真实的。”

肯·韦纳与一个小爵士乐团一起演奏萨克斯。图片来源:卡姆布伦·卡特

尽管目前世界对机器学习情有独钟,但这可能不是人工智能生成音乐的最终方法。“爵士乐中的深度学习同样淡化了音乐中至关重要的节奏、音色和纹理方面,”加州大学圣地亚哥分校音乐教授和萨克斯管演奏家大卫·博尔戈说,除了是我的朋友之外,他还撰写了《劳特利奇爵士研究指南》中关于即兴创作和计算机的引人入胜的章节。“该领域的研究倾向于让计算机演奏‘正确的音符’,但我们离设计出能够进行微观和宏观的时间、音色和纹理调整的系统还很遥远,这些调整对于与人类音乐家一起律动,并以非脚本化的方式发展高水平的集体即兴演奏(而不是坚持让人类音乐家与计算机一起即兴演奏或随计算机律动)是必要的。”

换句话说,即使我很幸运有一天能得到一个按需的机器人查理·帕克乐队伙伴,但在我们达到人类水平的通用人工智能的圣杯之前,这仍然可能是一种单方面的体验。