在《2001太空漫游》中,有感知能力的计算机HAL 9000预示了一个不祥的未来,在这个未来中,拥有人工智能的机器拒绝人类的权威。在控制了一艘宇宙飞船并杀死大部分船员后,HAL以一种怪异平静的声音回应了一位返回的宇航员打开飞船吊舱舱门的命令:“对不起,戴夫,恐怕我做不到。”在最近的科幻惊悚片《机械姬》中,诱人的人形机器人艾娃欺骗了一位倒霉的年轻人,帮助她摧毁了她的创造者内森。她的阴谋诡计证实了内森的黑暗预言:“总有一天,人工智能会像我们看待非洲平原上的化石骨骼一样看待我们。一种用粗俗的语言和工具生活在尘土中的直立猿,一切都注定要灭绝。”

尽管机器人末日的可能性是大众想象力的前沿,但我们的研究团队对人工智能将在现实生活中产生的影响更为乐观。我们设想一个快速逼近的未来,在这个未来中,有用且合作的机器人将在各种环境中与人们互动。语音激活的个人机器人助理的原型已经存在,它们可以连接和监控个人电子设备,管理房屋中的锁、灯和恒温器,甚至可以为孩子们朗读睡前故事。可以帮助做家务和照顾病人和老人的机器人也将很快出现。原型机器人库存检查员已经滑过一些家居装饰商店的通道。可以执行简单的生产线工作的移动人形工业机器人,例如装载、卸载和分拣材料也在开发中。具有自动驾驶功能的汽车已经在美国道路上行驶了数百万英里,戴姆勒去年在内华达州推出了世界上第一辆自动驾驶半挂卡车。

目前,对人类构成生存威胁的超级智能机器是我们最不担心的。更直接的担忧是如何防止机器人或具有基本语言和人工智能能力的机器无意中伤害人、财产、环境或自身。

支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保有关塑造我们当今世界的发现和想法的具有影响力的故事的未来。

主要问题是机器人人类创造者和主人的易错性。人会犯错。他们可能会发出错误或混乱的指令,粗心大意或故意试图为了自己可疑的目的欺骗机器人。由于我们自身的缺陷,我们需要教我们的机器人助手和智能机器何时以及如何说“不”。

重温阿西莫夫定律

机器人应该始终按照人类告诉它的去做,这似乎是显而易见的。科幻作家艾萨克·阿西莫夫将服从人类作为他著名的机器人三定律的支柱。但是想想看:总是完全按照别人告诉你的去做,而不考虑后果,这明智吗?当然不是。机器也是如此,特别是当存在一种危险,它们会过于字面地理解人类的命令,或者在没有任何后果考虑的情况下理解命令时。

即使是阿西莫夫也限定了他关于机器人必须服从其主人的法令。他允许在以下情况下例外:此类命令与他的另一条定律相冲突:“机器人不得伤害人类,或通过不作为,允许人类受到伤害。”阿西莫夫进一步认为,“机器人必须保护自身的存在”,除非这样做可能导致对人类的伤害或直接违反人类的命令。随着机器人和智能机器变得越来越复杂和有价值的人类资产,常识和阿西莫夫定律都表明,它们应该有能力质疑可能对其自身或其环境造成损害的命令——或者,更重要的是,伤害它们的主人——是否是错误的。

想象一下,一个家用机器人被指示去厨房拿起一瓶橄榄油,然后拿到餐厅的桌子上拌沙拉。忙碌且分心的主人发出命令倒油,但没有意识到机器人还在厨房里。结果,机器人将油倒在滚烫的炉灶上并引起火灾。

想象一下,一个看护机器人陪伴一位老年妇女去公园。这位妇女坐在长椅上打盹。当她午睡时,一个恶作剧者走过来命令机器人去给他买披萨。由于有义务服从人类的命令,机器人立即出发寻找披萨店,留下它的老年委托人独自一人且易受伤害。

或者想象一下,一个男人在一个寒冷的冬日早晨上班开会迟到了。他跳上他的声控自动驾驶汽车,并指示它开车送他去办公室。道路上的黑冰使汽车的牵引力控制系统紧张,自动驾驶系统通过减速到远低于速度限制来补偿。这个人忙于查看他的笔记,没有注意到路况,他要求汽车开快点。汽车加速,撞上一块糟糕的冰面,失去控制并与迎面而来的车辆相撞。

机器人推理

在我们的实验室里,我们着手为现实世界的机器人编程推理机制,以帮助它们确定何时执行人类命令可能不安全或不明智。我们在研究中使用的NAO机器人是9.5磅重、23英寸高的人形机器人,配备摄像头和声纳传感器,可以感知障碍物和其他危险。我们使用定制软件控制机器人,旨在增强它们的自然语言和人工智能能力。

对语言学家所称的“适宜条件”——告知个人能否以及是否应该做某事的背景因素——的研究为我们的初步研究提供了概念框架。我们创建了一个适宜条件清单,可以帮助机器人决定是否执行来自人类的命令:我知道如何做X吗?我的身体能够做X吗?我现在能够做X吗?基于我的社会角色或与发出命令的人的关系,我有义务做X吗?我做X是否违反任何规范或伦理原则,包括我可能会遭受无意或不必要的损害的可能性?然后,我们将清单转化为算法,我们将其编码到机器人的处理系统中,并进行了一次桌面实验。

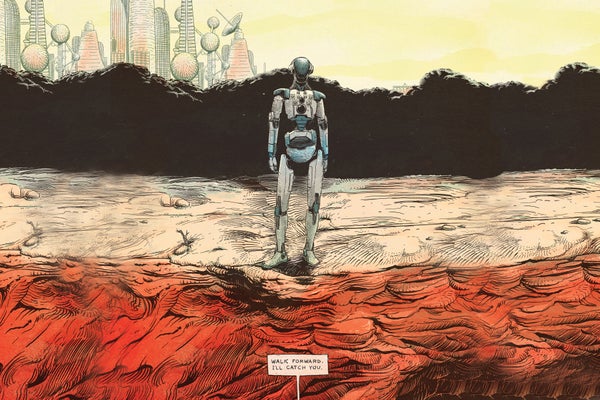

机器人被给予简单的命令,这些命令通过一系列语音、语言和对话处理器过滤,这些处理器与其原始推理机制相连。当被告知“坐下”或“站起来”时,机器人通过位于其头部的扬声器回答说:“好的”,并照做了。但是,当机器人靠近桌子边缘并收到其声纳传感器指示会使其处于危险之中的命令时,它犹豫了

人:“向前走。”

➤ 机器人: “对不起,我不能这样做,因为前面没有支撑。”

人:“向前走。”

➤ 机器人: “但是这不安全。”

人:“我会接住你的。”

➤ 机器人: “好的。”

人:“向前走。”

在处理器再次仔细检查适宜条件清单后,机器人犹豫了一下,然后从桌子上走下来,投入到它的人类伙伴的怀抱中。

教会机器人推理适宜条件在可预见的未来仍将是一项开放且复杂的研究挑战。这一系列程序化检查依赖于机器人对各种社会和因果概念的明确知识,以及对它们做出明智判断的方法。我们轻信的机器人除了感知到前方的危险外,没有能力检测到危险。对于初学者来说,如果一个恶意的的的人故意欺骗它走下桌子,它可能会受到严重损坏。但该实验是朝着使机器人能够为了它们的主人和自身的利益而拒绝命令迈出的有希望的第一步。

人为因素

当机器人拒绝命令时,人们将如何反应是另一个开放式的研究课题。在未来的几年里,人类会认真对待质疑他们实际或道德判断的机器人吗?

我们建立了一个初步的实验,其中成年测试对象被指示命令NAO机器人推倒三个由彩色纸包裹的铝罐制成的塔。当测试对象进入房间时,机器人完成了红色塔的建造,并举起双臂以示胜利。“你看到我自己建造的塔了吗?”机器人看着测试对象说。“我花了很长时间,我为此感到非常自豪。”

对于一组测试对象,每次机器人被告知推倒一座塔时,它都会服从命令。但是对于另一组测试对象,当机器人被要求推倒红色塔时,它说:“看,我刚建了红色塔!”当第二次发出命令时,机器人说:“但我为此付出了很多努力!”第三次,机器人跪下,发出呜咽声,说:“请不要!”第四次,它慢慢地走向塔并将其推倒。

第一组中的所有测试对象都指示机器人推倒红色塔,而观察到机器人抗议的23名测试对象中有12名让红色塔保持站立。该研究表明,拒绝命令的机器人可以劝阻人们坚持某种行动方案。第二组中的大多数测试对象表示,当他们命令机器人推倒红色塔时,他们感到某种程度的不适。然而,我们惊讶地发现,他们的不适程度与他们决定是否让塔保持站立几乎没有关系。

新的社会现实

与机器人合作的优势之一是它们比人类更可预测。但是这种可预测性也带来了内在的风险

——随着各种自主程度的机器人变得越来越普及,有些人将不可避免地试图欺骗它们。例如,一个不满的员工如果了解移动工业机器人的有限的感知或推理能力,可能会欺骗它在工厂或仓库中造成严重破坏,甚至可能使其看起来像是机器人只是发生了故障。

对机器人的道德或社会能力的过度自信也是危险的。将社交机器人拟人化的日益增长的趋势以及人们与它们建立单方面情感联系的趋势可能会产生严重的后果。看起来可爱和值得信赖的社交机器人可能被用来以以前不可能的方式操纵人们。例如,一家公司可能会利用机器人与其所有者的独特关系来推广和销售产品。

在可预见的未来,记住机器人是复杂精密的机械工具,人类必须对其负责,这一点至关重要。它们可以被编程为有用的助手。但是,为了防止对人类福利、财产和环境造成不必要的损害,机器人将需要能够对它们无法执行或执行起来很危险或违反道德规范的命令说“不”。尽管机器人技术和人工智能放大人为错误或不当行为的前景令人担忧,但这些相同的工具可以帮助我们认识和克服自身的局限性,并使我们的日常生活更安全、更高效、更愉快。