想象一下,一种武器在发射或扣动扳机时无需人类做出决定。想象一下,一种由人类编程来识别人类目标的武器,但随后却被留下来扫描其内部数据库,以决定一组身体特征是否意味着某人是朋友还是敌人。当人类犯错,向错误的目标开火时,抗议声震耳欲聋,惩罚也可能很严厉。但是,如果一台被编程来控制武器的计算机做出了开火的致命决定,而且它错了,我们会有什么反应,我们将追究谁的责任?

这不是电影;这些是代表们在四月份于维也纳举行的自主武器系统会议上考虑的各种问题。在这座以华尔兹舞而闻名的古典欧洲城市中心,当人们接孩子放学和喝咖啡时,专家演讲者手持麦克风坐在特殊的高级别小组中,讨论着机器的开发和使用可能很快就会变得无法挽回的非常现实的可能性,这些机器被编程为独立判断谁生谁死。

奥地利联邦欧洲和国际事务部长亚历山大·沙伦贝格说:“这是我们这一代人的‘奥本海默时刻’,”“我们不能让这一时刻白白流逝而不采取行动,现在是就国际规则和规范达成一致以确保人类控制的时候了。”

关于支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保有关塑造我们当今世界的发现和想法的具有影响力的故事的未来。

我作为一家日本媒体机构的联合国记者报道了这些会议,这些关于我们未来的非凡讨论与我们当下的平凡时刻并行发生——日本是历史上唯一遭受过核 бомбардировок 的国家,因此非常感兴趣。沙伦贝格的声明是正确的:迫切需要制定国际规则,以防止这些机器被完全放任,在战争中做出生死攸关的决定,这令人沮丧地紧迫。但是,实际的规则制定仍然很少。

第一个“奥本海默时刻”之后的几十年带来了一场暗流涌动的冷战和一个处于灾难性核 апокалипсис 边缘的世界。即使在今天,仍然存在严重威胁要使用核武器,尽管它们有能力摧毁文明并导致人类灭绝。我们真的想在其中加入自主武器吗?我们真的想武装那些可能将儿童的体温误认为士兵的计算机屏幕吗?我们想生活在一个由机器居住的世界里,这些机器可能在几分钟内选择大规模 бомбардировать 繁忙的城镇广场吗?立法的时机不是下周、明年、下个十年。就是现在。

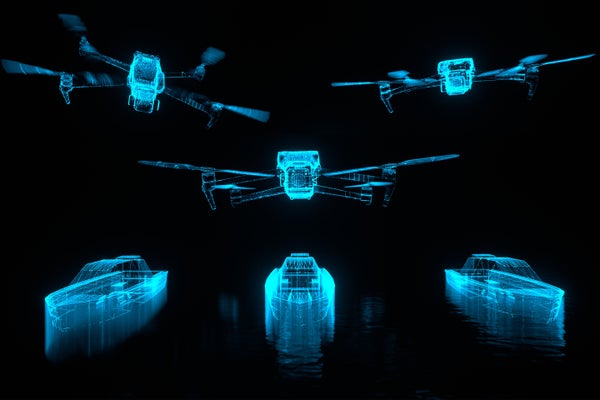

提到“杀手机器人”,你的脑海中会想到《终结者》,但是真正的杀手机器人可能更加隐蔽,伪装成屏幕上的计算机程序。武器本身可以采取多种形式:无人和潜水无人机;徘徊的“自杀”无人机,它们等待目标,然后猛扑攻击;具有反车辆和反人员地雷的防御系统;预编程的攻击导弹、火箭或飞机,它们根据标准打击目标;甚至用于大规模杀伤的无人机“蜂群”。

这些武器在人类的控制下存在——实际的人决定何时何地使用它们——但是,越来越多的程序员正在训练这些机器在没有人类按下象征性的红色按钮的情况下做出这些决定。这些机器如何被训练和测试至关重要。有些人认为,或许仍有机会阻止甚至更致命的自主武器的开发,但是,即使这在某种程度上是可能的,但现在显然至少需要制定关于其使用的规则。

这些武器甚至不再是未来的问题了;有报道称,在乌克兰战争中已经使用了完全自主无人机,以色列国防军(IDF)正在使用一个名为薰衣草的人工智能驱动的数据库来追踪和瞄准哈马斯成员。我们如何使用自主武器系统,这些决策背后的伦理,以及我们是否监管使用它们,已经成为激烈争论的地缘政治话题;过去几年,关注这些问题的会议数量呈指数级增长,例如维也纳会议。

世界和平领域的主要参与者已经意识到这些类型武器构成的威胁已有一段时间了。人权观察(HRW)大声疾呼制定国际立法,并多次声明,使用自主武器将“不符合国际人道主义法”。人权观察还共同创立了一个恰如其名的“停止杀手机器人”联盟,该联盟于 2013 年启动,坚决反对机器“决定谁生谁死”。

去年十月,联合国秘书长安东尼奥·古特雷斯和红十字国际委员会(ICRC)主席米里亚娜·斯波利亚里奇共同呼吁各国制定具体的禁止和限制措施,以便“保护今世后代免受其使用后果的影响”。自主武器系统也列入了大会议程,预计将在今年晚些时候的未来峰会上进行讨论。

尽管官员们做出了这些英勇的努力和令人望而生畏的奥本海默式声明,但在立法方面的进展仍然明显迟缓。

原因是什么?原因有很多,但有一点是肯定的:应该承担责任的国家没有承担责任。

美国国防部就自主武器发表了声明,承认其危险性,但尚未通过关于其开发或使用的明确规则,并且在幕后,美国国防部正在悄悄地投资军事人工智能和自主武器技术。据报道,截至 2023 年底,五角大楼已经在进行至少 800 个与人工智能相关的军事项目,并计划到 2026 年部署启用人工智能的自主军用车辆,以便跟上中国的技术进步。虽然美国已经发布了公开指令,承认武器被留给其自身编程判断的严重性,但这些指令包含漏洞,官员之前的声明对“适当程度的人类判断”和其他模棱两可的措辞的定义含糊不清。2023 年,美国政府提出了一项政治宣言,“以围绕负责任的行为建立国际共识,并指导各国开发、部署和使用军事人工智能。”但是,包括中国、俄罗斯、伊朗和印度在内的其他正在开发或对人工智能武器表现出兴趣的国家尚未签署。

奥本海默因在制造原子弹后重复引用“我现在成了死神,世界的毁灭者”这句话而闻名。八十年后,核武器依然存在,我们大多数人都不曾知道没有核武器的世界,而且,按照裁军的趋势发展,我们不太可能再次知道。

有了自主武器,我们正处于另一个“世界毁灭者”即将诞生的边缘。这一次它将是一台机器。一台无法感受的机器。一台不了解人性的机器。一台永远无法做出真正人类判断的机器。

技术正在超越立法,并且开始超越全人类。如果不能做更多的事情——现在,在这一刻,由能够做到的人来做——通过法律和条约来控制这项技术,那么,还有什么能阻止一场可怕的杀手机器人军备竞赛,以及致命的自主机器和悬而未决的终结者式战争威胁变得正常?如果做得不够,人类本身难道不会处于崩溃的边缘吗?

我们经历了漫长的时代进化,建立了社会,确立了人权,取得了发现,将人类送入太空,并治愈了一些最致命的疾病。人类,如此聪明,如此受人尊敬,如此遥遥领先。那么,我们为什么要做出如此愚蠢的事情,允许机器来判断我们生命的价值?我们为什么要冒着最终陷入我们自己不人道的人类创造的混乱之中,在我们自己毁灭的灰烬之中,因为我们赋予了算法和代码终止人类生命的能力?轨迹仍在继续,除非我们改变它。

这是一篇观点和分析文章,作者或作者表达的观点不一定代表《大众科学》的观点。