诺贝尔奖颁奖典礼于今年12月举行,表彰了与人工智能相关的研究,以及团体日本被爆者团体全国联合会 (Nihon Hidankyo)为结束核战争所做的努力。

这是一种引人注目的并置,身为研究深度学习原理的数学家,我对此感触颇深。在20世纪上半叶,诺贝尔委员会向物理学和化学领域的发现颁发了奖项,这些发现揭示了原子的结构。这项工作也促成了核武器的开发和随后的部署。几十年后,诺贝尔委员会将今年的和平奖颁发给了为抵消核科学最终被利用的方式而努力的工作。

基础物理学研究发展出核武器,这与人工智能应用带来的风险之间存在相似之处,而人工智能的应用则源于计算机科学基础研究。这些风险包括即将上任的特朗普政府推动人工智能“曼哈顿计划”,以及更广泛的社会风险,包括虚假信息、工作岗位流失和监控。

关于支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道: 订阅。通过购买订阅,您将有助于确保有关塑造我们当今世界的发现和想法的具有影响力的故事能够拥有未来。

我担心我和我的同事们与我们的工作可能产生的影响联系不足。诺贝尔委员会是否会在下个世纪将和平奖颁发给那些清理人工智能科学家留下的烂摊子的人们?我决心不让核武器的故事重演。

大约80年前,数百名世界顶尖科学家加入了曼哈顿计划,竞相在纳粹之前制造出原子武器。然而,即使在德国的炸弹计划于1944年停止后,甚至在德国次年投降后,洛斯阿拉莫斯的工作仍在继续,没有停顿。

即使纳粹的威胁已经结束,只有一位曼哈顿计划的科学家——约瑟夫·罗特布拉特——离开了该项目。回顾过去,罗特布拉特解释说:“你会以某种方式让自己投入其中,然后忘记自己是个人。这变成了一种瘾,你只是为了生产一个小玩意而继续下去,而没有考虑后果。然后,完成之后,你就会为自己生产了它找到一些理由。而不是反过来。”

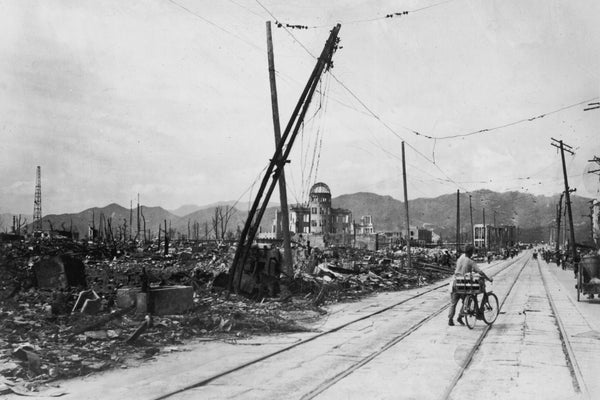

美国军方不久后进行了首次核试验。然后,美国领导人授权于8月6日和9日对广岛和长崎进行了两次轰炸。炸弹炸死了数十万日本平民,其中一些人当场死亡。另一些人则在多年甚至几十年后死于辐射中毒的影响。

尽管罗特布拉特的话是几十年前写的,但它们是对当今人工智能研究中普遍存在的精神的令人毛骨悚然的准确描述。

当我最初在普林斯顿高等研究院工作时,开始看到核武器和人工智能之间的相似之处,克里斯托弗·诺兰的电影《奥本海默》令人难忘的结尾场景就设定在那里。在理解人工神经网络的数学内部运作方面取得了一些进展后,我也开始担心我的工作最终可能带来的社会影响。在一位同事的建议下,我去与时任该研究所所长的物理学家罗伯特·迪克格拉夫交谈。

他建议我从罗伯特·奥本海默的人生故事中寻求指导。我读了一本传记,又读了一本。我试图猜测迪克格拉夫的想法,但我在奥本海默的道路上没有看到任何吸引人的东西,当我读完第三本传记时,我唯一清楚的是,我不希望自己的人生重蹈他的覆辙。我不希望在生命的尽头背负像奥本海默那样的负担。

奥本海默经常被引述说,当科学家们“看到一些技术上很吸引人的东西时,[他们]就会继续做下去。”事实上,2024年诺贝尔物理学奖得主之一杰弗里·辛顿曾引用过这句话。但这并非普遍真理。当时的杰出女物理学家莉泽·迈特纳被邀请加入曼哈顿计划。尽管她是犹太人,并且侥幸逃脱了纳粹的占领,但她断然拒绝,说:“我不会参与炸弹的制造!”

罗特布拉特也为科学家如何应对在发挥才能的同时又不忘价值观的挑战提供了另一种模式。战后,他重返物理学领域,专注于辐射的医疗用途。他还通过1957年共同创立的普格沃什科学与世界事务会议,成为核不扩散运动的领导者。1995年,他和他的同事因这项工作而被授予诺贝尔和平奖。

现在,和那时一样,在人工智能的发展中,也有一些深思熟虑、脚踏实地的人脱颖而出。采取了类似于罗特布拉特的立场,埃德·牛顿-雷克斯去年从 Stability AI 辞去了领导音乐生成团队的职位,原因是该公司坚持在未经付费的情况下,使用受版权保护的数据训练生成式人工智能模型。今年,苏奇尔·巴拉吉也因类似的担忧从 OpenAI 辞去了研究员的职务。

与迈特纳拒绝从事其发现的军事应用相呼应,在2018年的一次公司内部全体员工大会上,梅雷迪思·惠特克表达了员工对“Maven 项目”的担忧,这是一个国防部合同,旨在开发人工智能以支持军用无人机瞄准和监视。最终,员工成功地向谷歌施压,迫使这家2024年诺贝尔物理学奖得主戴密斯·哈萨比斯工作的公司放弃了该项目。

社会在许多方面影响着科学家的工作。直接的影响是经济上的;我们集体选择资助哪些研究,个人选择为哪些研究成果付费。

间接但非常有效的一种影响是声望。大多数科学家都关心他们的遗产。当我们回顾核时代——例如,当我们选择拍摄一部关于奥本海默以及那个时代的科学家的电影时——我们向今天的科学家们发出了关于我们重视什么的信号。当诺贝尔奖委员会选择奖励今天从事人工智能研究的人时,他们为今天和未来的人工智能研究人员设定了强大的激励。

改变20世纪的事件已经太晚了,但我们可以期待人工智能取得更好的结果。我们可以从关注那些专注于快速发展能力的人工智能机器学习领域之外的人开始,转而效仿牛顿-雷克斯和惠特克这样的人,他们坚持参与其工作的背景,并且不仅有能力评估,而且有能力应对不断变化的环境。关注像他们这样的科学家所说的话,将为现在和未来的积极科学发展提供最佳希望。

作为一个社会,我们可以选择提升、效仿和树立哪些人作为下一代的榜样。正如核时代教给我们的那样,现在是时候认真评估科学发现的哪些应用,以及今天的科学家中的哪些人,反映的不是我们目前生活的世界的价值观,而是我们希望居住的世界的价值观。

这是一篇观点和分析文章,作者或作者表达的观点不一定代表《大众科学》的观点。