一个小孩可以看到眼前的任何东西,并描述他们所看到的——但对于人工智能系统来说,这是一项艰巨的任务。这是因为它结合了两项独立的技能:识别物体的能力以及生成描述场景的句子的能力。多伦多大学和蒙特利尔大学的科学家们开发出软件,该软件以脑细胞网络为模型,他们声称该软件可以拍摄任何图像并生成标题,并且在大多数情况下都能正确识别。

他们的方法建立在早期涉及自然语言处理的工作基础上——自然语言处理是指将语音或文本从一种语言转换为另一种语言的能力,或者更广泛地说,是从单词和句子中提取含义的能力。“这既是图像信息与自然语言的结合,”多伦多大学的计算机科学家理查德·泽梅尔说。“这就是这里的新颖之处——图像和文本的结合。我们认为这是一个翻译问题,”他指出。“当您尝试将一个句子从英语翻译成法语时,您必须首先理解英语句子的含义,然后将其转换为法语。在这里,您需要图像的含义,内容;然后您可以将其翻译成文本。”

但是,软件模型如何“知道”图像中有什么呢?在系统可以处理不熟悉的图片之前,它需要在一个庞大的数据集上进行训练——实际上是三个不同的数据集,其中包含超过 120,000 张已经添加标题的图像。该模型还需要了解在正常的英语句子中,哪些词可能与其他词一起出现。例如,一个导致模型生成单词“boat”(船)的图像,很可能也会使用单词“water”(水),因为这些词通常一起出现。此外,它对图像中什么重要也有一定的概念。泽梅尔指出,例如,如果图像中有人,模型往往会在标题中提到这一点。

支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保有关当今塑造我们世界的发现和思想的具有影响力的故事的未来。

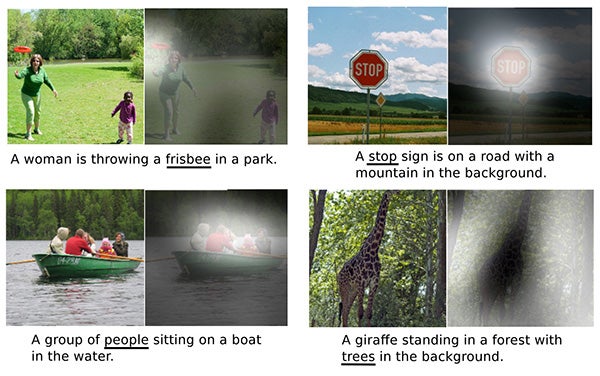

通常,结果是完全正确的。对于一张图像,它生成的标题是“路上的停车标志,背景是山”——正如图像显示的那样;对于“一位女士正在公园里扔飞盘”和“一只长颈鹿站在背景有树木的森林中”的描述也很准确。但偶尔也会出错。当一张图像包含两只彼此靠近但远离相机的长颈鹿时,它将它们识别为“一只大型白色鸟”。而一个蔬菜摊后面的小贩得到的标题是“一位女士正坐在放着大披萨的桌子旁”。有时,看起来相似的物体只是被误认为彼此——例如,一个用锡箔纸包裹的三明治可能会被误认为是一部手机(特别是当有人把它放在脸附近时)。泽梅尔说,在他们的测试中,该模型生成的标题“可以被误认为是人类的标题”的概率约为 70%。

泽梅尔说,一个潜在的应用可能是作为视力障碍人士的辅助工具。盲人可能会拍摄他们面前的任何东西的照片,并要求系统生成一个描述场景的句子。它还可以帮助完成原本费力的图像标记任务。(媒体机构可能想要立即找到所有儿童玩冰球或工厂组装汽车的档案图像——如果硬盘驱动器上的数千张图像尚未标记,这将是一项艰巨的任务。)

图片来源:Microsoft COCO/Kelvin Xu 等人

该模型在思考吗?“该模型正在做的事情与大脑正在做的事情之间存在类比,”泽梅尔说,特别是在表示外部世界以及将“注意力”集中在场景的特定部分方面。“它正在朝着我们想要实现的目标前进,即让机器能够以一种反映理解的方式构建我们日常世界的表示。”

泽梅尔和他的同事们将在七月举行的国际机器学习会议上发表一篇关于这项工作的论文“展示、关注和讲述:基于视觉注意力的神经图像字幕生成”。