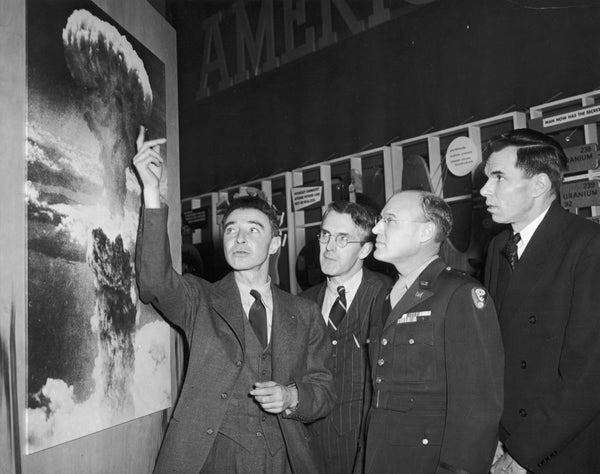

八十一年前,富兰克林·D·罗斯福总统委任年轻的物理学家 J. 罗伯特·奥本海默在新墨西哥州洛斯阿拉莫斯建立一个秘密实验室。奥本海默和他的同事们的任务是开发世界上第一批核武器,代号为曼哈顿计划。不到三年后,他们成功了。1945 年,美国在日本的广岛和长崎市投放了这些武器,造成数十万人死亡。

奥本海默因此被称为“原子弹之父”。尽管他对自己在战时的工作和技术成就感到沾沾自喜,但他后来也开始公开表示需要控制这项危险技术。

但是美国没有听取他的警告,地缘政治恐惧反而占据了上风。美国竞相部署威力越来越大的核系统,却鲜有认识到这些武器将造成的巨大且不成比例的危害。官员们也无视奥本海默关于加强国际合作以监管核技术的呼吁。

支持科学新闻报道

如果您喜欢这篇文章,请考虑支持我们屡获殊荣的新闻报道,方式是 订阅。通过购买订阅,您将有助于确保有关塑造我们今天世界的发现和思想的具有影响力的故事的未来。

奥本海默的例子也为我们今天提供了教训。我们绝不能在人工智能上重蹈我们在核武器上犯过的错误。

我们仍处于一场承诺中的人工智能革命的早期阶段。科技公司正在竞相构建和部署人工智能驱动的大型语言模型,例如 ChatGPT。监管机构需要跟上步伐。

尽管人工智能承诺带来巨大的好处,但它已经暴露了其危害和滥用的潜力。今年早些时候,美国 Surgeon General 发布了一份关于青少年心理健康危机的报告。报告发现,2021 年,三分之一的少女曾考虑过自杀。数据是明确的:大型科技公司是问题的重要组成部分。人工智能只会放大这种操纵和剥削。人工智能的性能依赖于剥削性的劳动实践,包括国内和国际。庞大而不透明的人工智能模型以有问题的数据为食,往往会加剧社会中现有的偏见——影响到一切,从刑事判决和警务到医疗保健、贷款、住房和招聘。此外,运行此类能源密集型人工智能模型的环境影响,给已经因气候变化的影响而摇摇欲坠的脆弱生态系统带来了压力。

人工智能还可能使潜在的危险技术更容易被流氓分子获取。去年,研究人员要求一个生成式人工智能模型设计新的化学武器。它在六小时内设计了 40,000 种潜在的武器。早期版本的 ChatGPT 生成了炸弹制造说明。麻省理工学院的一个课堂练习最近证明了人工智能如何帮助创建合成病原体,这可能会引发下一次大流行。通过传播获取此类危险信息的途径,人工智能有可能成为计算机化的突击武器或高容量弹匣:一个流氓分子释放前所未有的毁灭性危害的工具。

然而,竞相部署未经测试的人工智能的不仅是公司和私人行为者。我们也应该警惕政府推动人工智能军事化。我们已经拥有一个岌岌可危地建立在相互确保摧毁基础上的核武器发射系统,在感知到即将到来的袭击时,世界各国领导人只有几分钟的时间来决定是否发射核武器。人工智能驱动的核武器发射系统自动化可能很快就会取消“人在回路中”的做法——这是确保有缺陷的计算机智能不会导致核战争的必要保障,而核战争已经非常接近多次发生。旨在让决策者在日益复杂的世界中拥有更大应对能力的军事自动化竞赛可能会导致冲突失控。如果各国竞相采用军事化人工智能技术,我们都将成为输家。

正如 20 世纪 40 年代一样,现在是塑造这项新兴且可能危险的技术发展的关键窗口期。奥本海默认识到,美国应该甚至与其最深的对抗者合作,以国际上控制核技术的危险一面——同时继续追求其和平用途。美国谴责这个人及其想法,反而通过开发氢弹以及相关的昂贵且有时离奇的运载系统和大气层测试,开启了大规模的冷战军备竞赛。由此产生的核工业综合体对最脆弱的群体造成了不成比例的伤害。铀矿开采和大气层测试导致包括新墨西哥州居民、马绍尔群岛社区和纳瓦霍族成员在内的群体患上癌症。浪费性支出、机会成本以及对边缘化社区的影响是不可估量的——更不用说随之而来的无数次险情和核武器扩散了。今天,我们需要国际合作和国内监管,以确保人工智能安全发展。

国会现在必须采取行动监管科技公司,以确保它们将集体公共利益放在首位。国会应首先通过我的《儿童在线隐私保护法》、我的《算法正义和在线透明度法案》以及我的禁止人工智能发射核武器的法案。但这仅仅是开始。在白宫的《人工智能权利法案蓝图》的指导下,国会需要通过广泛的法规,以阻止这种鲁莽地竞相构建和部署不安全的人工智能的行为。关于如何以及在何处使用人工智能的决策不能仅由科技公司来决定。它们必须以最容易受到人工智能剥削和伤害的社区为中心来制定。我们必须对与盟友和对手合作持开放态度,以避免人工智能在军事和民用方面的滥用。

在核时代开始时,美国没有听取奥本海默关于军备竞赛危险的警告,而是鸣响了发令枪。八十年后,我们有道义责任和明确的利益不重蹈覆辙。

这是一篇观点和分析文章,作者或作者表达的观点不一定代表《大众科学》的观点。