开发能够像人类一样推理的灵活机器学习模型的关键可能不是向它们提供海量训练数据。相反,一项新的研究表明,答案可能在于如何训练它们。这些发现可能是朝着更好、更少出错的人工智能模型迈出的重要一步,并可能有助于阐明人工智能系统——以及人类——如何学习的秘密。

人类是混音大师。当人们理解一组成分(如食物配料)之间的关系时,我们可以将它们组合成各种美味的食谱。对于语言,我们可以理解以前从未遇到过的句子,并撰写复杂、原创的回应,因为我们掌握了词语的潜在含义和语法规则。在技术术语中,这两个例子都是“组合性”或“系统泛化”的证据——通常被视为人类认知的关键原则。“我认为这是智能最重要的定义,”约翰·霍普金斯大学的认知科学家保罗·斯莫伦斯基说。“你可以从了解部分到处理整体。”

真正的组合性可能是人类思维的核心,但机器学习开发者几十年来一直在努力证明人工智能系统能够实现它。已故哲学家和认知科学家杰里·福多和芝诺·皮利辛提出的一个35年前的论点认为,对于标准神经网络来说,这一原则可能遥不可及。今天的生成式人工智能模型可以模仿组合性,对书面提示产生类似人类的回应。然而,即使是最先进的模型,包括 OpenAI 的 GPT-3 和 GPT-4,仍然达不到这一能力的一些基准。例如,如果你向 ChatGPT 提问,它最初可能会提供正确的答案。但是,如果你继续向它发送后续查询,它可能会无法保持主题,或者开始自相矛盾。这表明,尽管这些模型可以从它们的训练数据中回 regurgitate 信息,但它们并没有真正掌握它们产生的句子背后的含义和意图。

支持科学新闻报道

如果您喜欢这篇文章,请考虑通过订阅来支持我们屡获殊荣的新闻报道。通过购买订阅,您正在帮助确保有关塑造我们今天世界的发现和想法的有影响力的故事的未来。 订阅。通过购买订阅,您正在帮助确保有关塑造我们今天世界的发现和想法的有影响力的故事的未来。

但是,根据周三发表在《自然》杂志上的一项研究,一种专注于塑造神经网络学习方式的新型训练协议可以提高人工智能模型像人类一样解释信息的能力。研究结果表明,某种人工智能教育方法可能创建组合式机器学习模型,使其至少在某些情况下能够像人类一样进行泛化。

“这项研究取得了重要的突破,”未参与该研究的斯莫伦斯基说。“它完成了一些我们一直想完成但以前没有成功的事情。”

为了训练一个似乎能够重组组件并理解新颖、复杂表达方式含义的系统,研究人员不必从头开始构建人工智能。“我们不需要从根本上改变架构,”该研究的主要作者、纽约大学的计算认知科学家布伦丹·莱克说。“我们只需要给它练习。”研究人员从一个标准的 Transformer 模型开始——该模型是支持 ChatGPT 和 Google 的 Bard 的那种人工智能支架,但缺乏任何先前的文本训练。他们让这个基本的神经网络通过一套专门设计的任务,旨在教程序如何理解一种虚构的语言。

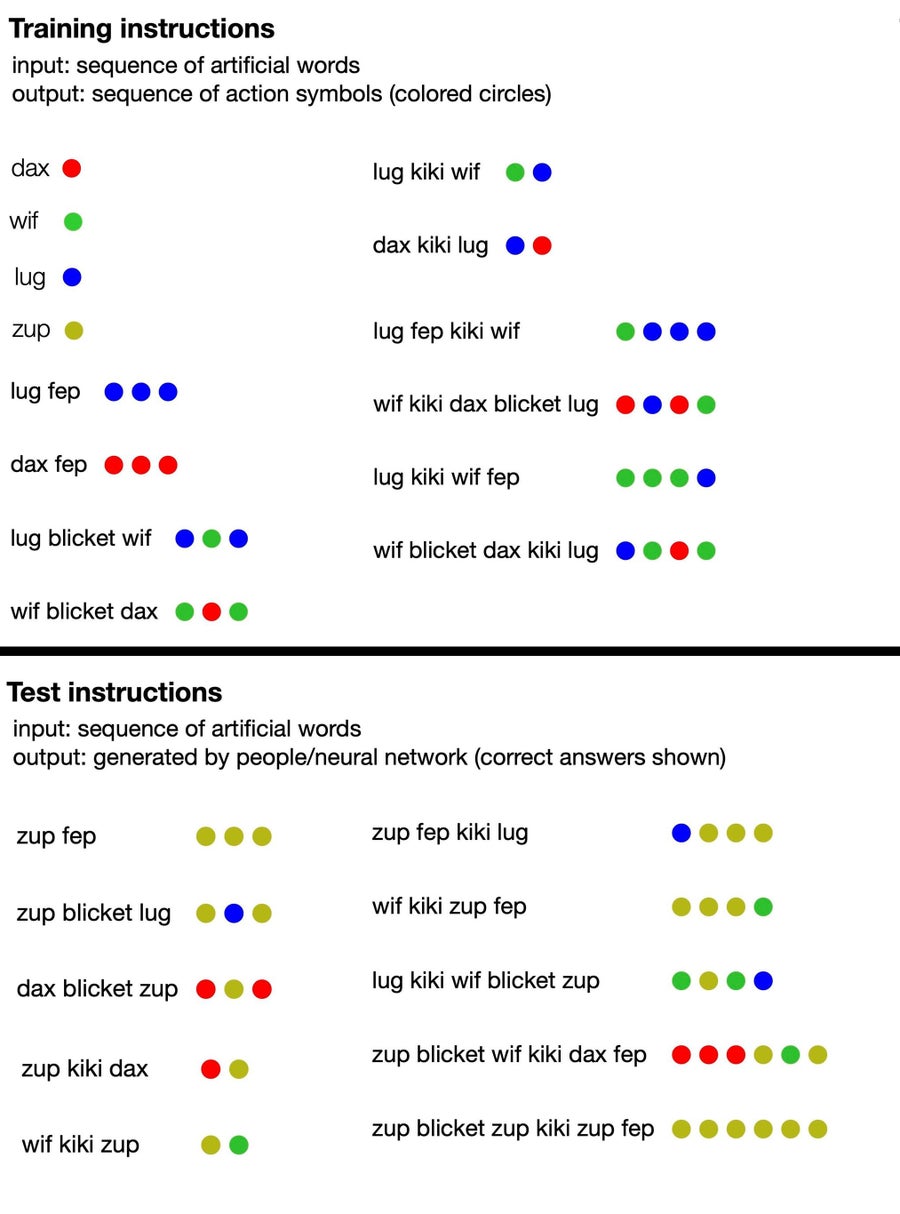

该语言由无意义的词语组成(如“dax”、“lug”、“kiki”、“fep”和“blicket”),这些词语“翻译”成一组彩色点。其中一些虚构的词语是符号术语,直接表示某种颜色的点,而另一些则表示改变点输出顺序或数量的函数。例如,dax 代表一个简单的红点,但 fep 是一个函数,当与 dax 或任何其他符号词配对时,会将其对应的点输出乘以三。所以“dax fep”会翻译成三个红点。然而,人工智能训练不包括任何这些信息:研究人员只是向模型提供了一些无意义的句子示例,并附带相应的点集。

从那里,研究作者提示模型产生其自己的一系列点来响应新的短语,并根据人工智能是否正确遵循了该语言的隐含规则对其进行评分。很快,神经网络就能够连贯地响应,遵循无意义语言的逻辑,即使在引入新的词语配置时也是如此。这表明它可以“理解”该虚构语言的虚构规则,并将它们应用于它没有接受过训练的短语。

来自计算认知科学家 Brenden Lake 及其同事关于一项新的Nature研究的新闻稿中的一张图表显示了人类参与者和人工智能模型都收到的训练材料(顶部),以及他们接受测试的提示类型和正确答案(底部)。 鸣谢:Brenden Lake

此外,研究人员测试了他们训练有素的人工智能模型对虚构语言的理解,并与 25 名人类参与者进行了比较。他们发现,在最佳状态下,他们优化的神经网络的响应准确率达到 100%,而人类答案的正确率约为 81%。(当团队向 GPT-4 提供语言的训练提示,然后向其提出测试问题时,大型语言模型的准确率仅为 58%。) 鉴于额外的训练,研究人员的标准 Transformer 模型开始非常逼真地模仿人类推理,以至于它也犯了同样的错误:例如,人类参与者经常犯错,他们假设特定词语和点之间存在一对一的关系,即使许多短语不遵循该模式。当模型被提供这种行为的例子时,它很快开始复制它,并且犯错的频率与人类相同。

考虑到模型的小尺寸,模型的性能尤其引人注目。“这不是一个在整个互联网上训练的大型语言模型;这是一个相对较小的 Transformer 模型,专门针对这些任务进行训练,”未参与这项新研究的麻省理工学院的计算机科学家 Armando Solar-Lezama 说。“有趣的是,尽管如此,它还是能够表现出这些类型的泛化能力。” 这一发现暗示,与其仅仅向机器学习模型中塞入越来越多的训练数据,不如采取一种互补策略,为人工智能算法提供相当于专注的语言学或代数课程。

Solar-Lezama 说,这种训练方法理论上可以为更好的人工智能提供另一条途径。“一旦你向模型提供了整个互联网,就没有第二个互联网可以提供给它以进一步改进。因此,我认为迫使模型更好地推理的策略,即使在合成任务中,也可能对未来产生影响,”他说——但同时警告说,扩展新的训练协议可能存在挑战。同时,Solar-Lezama 认为,对较小模型的研究有助于我们更好地理解神经网络的“黑匣子”,并可能阐明更大的人工智能系统的所谓的新兴能力。

斯莫伦斯基补充说,这项研究以及未来类似的工作,也可能提高人类对自身思维的理解。这可能有助于我们设计系统,最大限度地减少我们人类容易出错的倾向。

然而,目前,这些好处仍然是假设性的——并且存在一些很大的局限性。“尽管他们的算法取得了成功,但它并没有解决提出的所有挑战,”未参与该研究的卡内基梅隆大学的计算机科学家 Ruslan Salakhutdinov 说。“它不会自动处理未经练习的泛化形式。” 换句话说,训练协议帮助模型擅长于一种类型的任务:学习虚构语言中的模式。但是,如果给定一个全新的任务,它就无法应用相同的技能。这在基准测试中很明显,模型无法处理更长的序列,也无法理解以前未引入的“词语”。

至关重要的是,每位《大众科学》采访的专家都指出,能够进行有限泛化的神经网络与通用人工智能的圣杯截然不同,后者是指计算机模型在大多数任务中超越人类能力。你可以说,“这是朝着那个方向迈出的非常非常非常小的一步,”Solar-Lezama 说。“但我们谈论的不是人工智能自行获得能力。”

从与人工智能聊天机器人的有限互动(可以呈现出超强能力的错觉)以及大量流传的炒作来看,许多人可能对神经网络的能力抱有夸大的想法。“有些人可能会感到惊讶,像 GPT-4 这样的系统真的很难开箱即用地完成这些类型的语言泛化任务,”Solar-Lezama 说。不过,这项新研究的发现虽然令人兴奋,但可能会无意中起到现实检验的作用。“真正重要的是要跟踪这些系统能够做什么,”他说,“以及它们不能做什么。”