当我要求 ChatGPT 说出Spektrum der Wissenschaft(《大众科学》的德语姊妹刊物)的主编时,答案是:“我掌握的最新信息截至 2021 年,当时弗洛里安·弗赖斯特特博士是Spektrum der Wissenschaft的主编。但是,信息可能自那时以来已更改。” 这突显了当前缺点之一,即当前的语言生成人工智能程序:它们会“产生幻觉”。虽然 Spektrum der Wissenschaft 刊登了许多 弗赖斯特特的著作,但他从未担任过 Spektrum der Wissenschaft 的员工,更不用说主编了。这就是为什么致力于所谓的“可解释人工智能”(XAI)模型非常重要的原因,这些模型可以证明其答案的合理性,从而变得更加透明。

大多数人工智能程序的功能就像一个“黑匣子”。“我们确切地知道模型做了什么,但不知道它为什么现在特别识别出一张图片显示的是猫,”德国达姆施塔特工业大学的计算机科学家克里斯蒂安·科斯廷在德语报纸Handelsblatt上说。 这种困境促使科斯廷——以及达姆施塔特工业大学的计算机科学家帕特里克·施拉莫夫斯基,以及德国海德堡人工智能公司 Aleph Alpha 的比约恩·戴泽罗斯、马尤克·德布和塞缪尔·魏因巴赫——今年早些时候推出了一个名为 AtMan 的算法。AtMan 允许 ChatGPT、Dall-E 和 Midjourney 等大型人工智能系统最终解释其输出。

2023 年 4 月中旬,Aleph Alpha 将 AtMan 集成到其自身的语言模型 Luminous 中,从而使人工智能能够推理其输出。那些想亲身尝试的人可以免费使用 Luminous 游乐场,用于诸如总结文本或完成输入等任务。例如,“我喜欢吃汉堡配”之后是答案“薯条和沙拉”。然后,借助 AtMan,可以确定哪些输入词导致了输出:在本例中是“汉堡”和“最喜欢”。

支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保有关当今塑造我们世界的发现和想法的具有影响力的故事的未来。

然而,AtMan 的解释能力仅限于输入数据。它确实可以解释“汉堡”和“喜欢”这两个词最强烈地促使 Luminous 用“薯条和沙拉”完成输入。但它无法推理 Luminous 如何知道汉堡通常与薯条和沙拉一起食用。这种知识仍然存在于模型训练的数据中。

AtMan 也无法揭穿人工智能系统讲述的所有谎言(所谓的幻觉)——例如弗洛里安·弗赖斯特特是我的老板。然而,从输入数据中解释人工智能推理的能力提供了巨大的优势。例如,可以快速检查人工智能生成的摘要是否正确,并确保人工智能没有添加任何内容。这种能力从伦理角度也起着重要作用。“例如,如果银行使用算法来计算一个人的信用度,则可以检查哪些个人数据导致了该结果:人工智能是否使用了歧视性特征,例如肤色、性别等等?” AtMan 的共同开发者戴泽罗斯说。

此外,AtMan 不仅限于纯语言模型。它还可以用于检查生成或处理图像的人工智能程序的输出。这不仅适用于 Dall-E 等程序,也适用于分析医学扫描以诊断各种疾病的算法。这种能力使人工智能生成的诊断更易于理解。如果人工智能识别出以前人类忽略的模式,医生甚至可以从中学习。

人工智能算法是一个“黑匣子”

“人工智能系统发展极其迅速,有时过早地集成到产品中,”也参与了 AtMan 开发的施拉莫夫斯基说。“重要的是我们理解人工智能如何得出结论,以便我们能够改进它。” 这是因为算法仍然是一个“黑匣子”:虽然研究人员了解它们的一般功能,但通常不清楚为什么特定的输出会跟随特定的输入。更糟糕的是,如果将相同的输入连续多次运行模型,则输出可能会有所不同。原因是人工智能系统的工作方式。

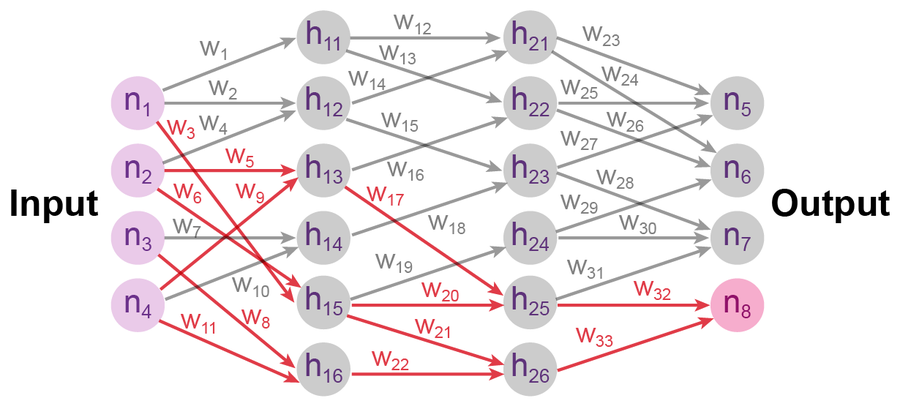

现代人工智能系统——例如语言模型、机器翻译程序或图像生成算法——由神经网络构建而成。这些网络的结构基于大脑的视觉皮层,其中称为神经元的单个细胞通过称为突触的连接相互传递信号。在神经网络中,计算单元充当“神经元”,它们逐层构建。与大脑中一样,机械神经元之间的连接称为“突触”,每个突触都分配有一个称为“权重”的数值。

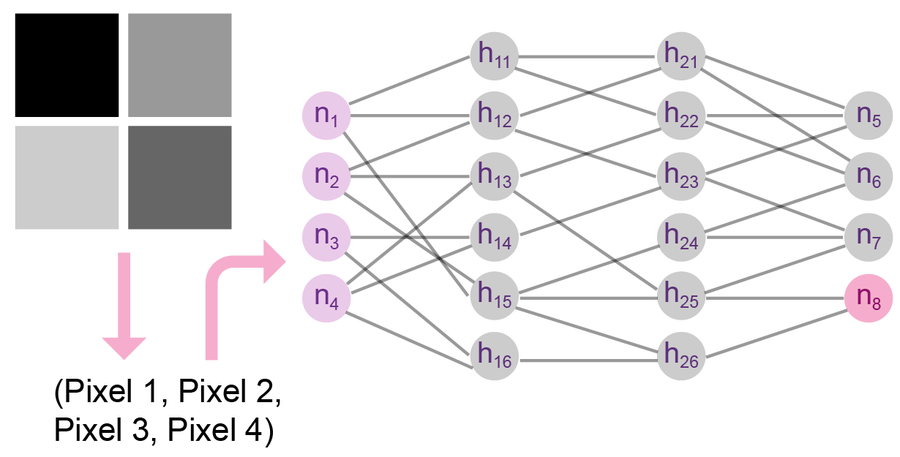

例如,如果用户想要将图像传递给这样的程序,则首先将视觉图像转换为数字列表,其中每个像素对应一个条目。第一层的神经元然后接受这些数值。

神经网络是一种算法,其结构模仿人脑结构。它由充当神经元的计算单元组成,标记为“n”(代表神经元)和“h”(代表隐藏神经元),以及合适的权重,标记为“w”,这些权重由训练确定。 来源:Manon Bischoff/Spektrum der Wissenschaft,由大众科学设计

接下来,数据逐层通过神经网络:一层中神经元的值乘以突触的权重,并传输到下一层的神经元。如有必要,此处的结果必须添加到终止于同一神经元的其他突触的值。因此,程序逐层处理原始输入,直到最后一层的神经元提供输出——例如,图像中是否有猫、狗或海鸥。

一个带有四个像素的图像,可以由神经网络处理。 来源:Manon Bischoff/Spektrum der Wissenschaft,由大众科学设计

但是,如何确保网络以产生有意义的结果的方式处理输入数据呢?为此,权重——突触的数值——必须正确校准。如果设置得当,程序可以描述各种各样的图像。您无需自己配置权重;相反,您需要对人工智能进行训练,使其找到尽可能合适的数值。

其工作原理如下:神经网络从权重的随机选择开始。然后,程序会收到数万或数十万个示例图像,所有图像都带有相应的标签,例如“海鸥”、“猫”和“狗”。网络处理第一个图像并产生一个输出,该输出与给定的描述进行比较。如果结果与模板不同(最初很可能就是这种情况),则所谓的反向传播就会启动。这意味着算法在网络中向后移动,跟踪哪些权重显着影响了结果——并修改它们。该算法对所有训练数据重复处理、检查和权重调整的组合。如果训练成功,则该算法甚至可以正确描述以前未见过的图像。

理解人工智能结果的两种方法

然而,通常,有趣的不仅是人工智能的答案,还有什么信息导致了它的判断。例如,在医学领域,人们想知道为什么程序认为它在扫描中检测到疾病迹象。为了找到答案,人们当然可以查看训练模型的源代码本身,因为它包含所有信息。但是,现代神经网络具有数千亿个参数——因此不可能跟踪所有这些参数。

尽管如此,仍然存在使人工智能结果更透明的方法。有几种不同的方法。一种是反向传播。与训练过程一样,人们可以追溯输出是如何从输入数据生成的。为此,必须回溯网络中权重最高的“突触”,从而推断出对结果影响最大的原始输入数据。

另一种方法是使用扰动模型,其中人类测试人员可以稍微更改输入数据,并观察这如何改变人工智能的输出。这使得人们可以了解哪些输入数据对结果影响最大。

这两种 XAI 方法已被广泛使用。但它们在 ChatGPT、Dall-E 或 Luminous 等具有数十亿个参数的大型人工智能模型中失败了。例如,反向传播缺乏必要的内存:如果 XAI 向后遍历网络,则必须记录数十亿个参数。虽然在大型数据中心训练人工智能是可能的,但不能不断重复相同的方法来检查输入。

在扰动模型中,限制因素不是内存,而是计算能力。例如,如果想知道图像的哪个区域对人工智能的响应起决定性作用,则必须单独更改每个像素,并在每个实例中生成新的输出。这需要大量时间以及实际不可用的计算能力。

为了开发 AtMan,科斯廷的团队成功地为大型人工智能系统调整了扰动模型,从而使必要的计算能力保持在可管理的范围内。与传统算法不同,AtMan 不直接改变输入值,而是修改已经在网络中更深层的数据。这节省了大量的计算步骤。

用于 Transformer 模型的“可解释人工智能”

要理解这是如何工作的,您需要了解 ChatGPT 等人工智能模型的功能。这些是一种特定类型的神经网络,称为 Transformer 网络。它们最初是为处理自然语言而开发的,但现在也用于图像生成和识别。

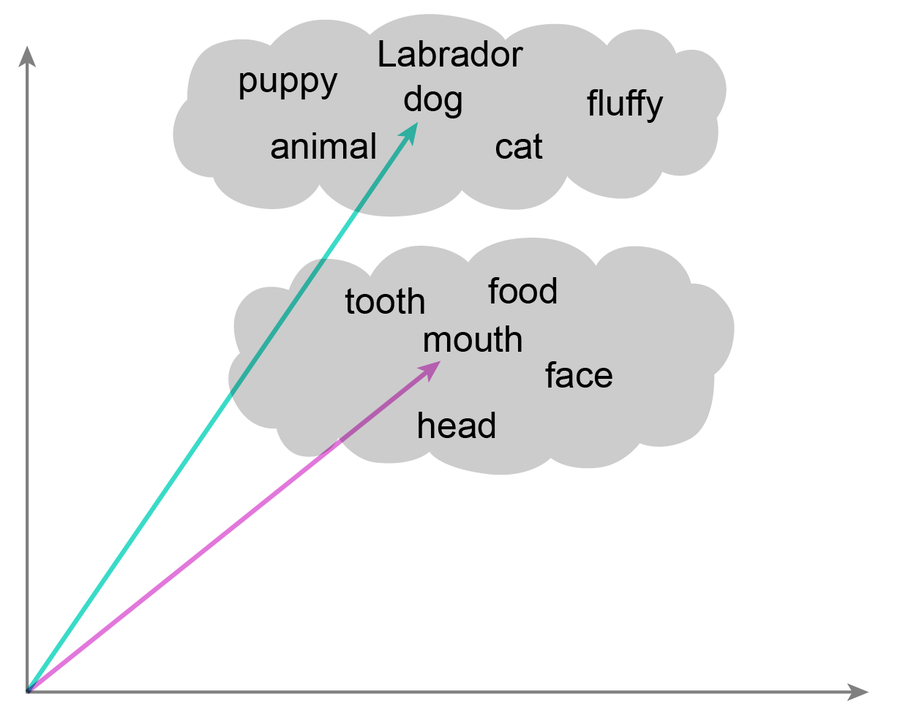

处理语音中最困难的任务是将单词转换为合适的数学表示形式。对于图像,此步骤很简单:将其转换为像素值长列表。如果两个列表的条目彼此接近,则它们也对应于视觉上相似的图像。必须为单词找到类似的过程:语义上相似的单词(如“房屋”和“小屋”)应具有相似的表示形式,而拼写相似但含义不同的单词(如“房屋”和“鼠标”)在数学形式上应相距更远。

在创建语言模型时,最困难的任务之一是以适当的方式呈现单词。含义相似的表达也应在数学表示中相似。 来源:Manon Bischoff/Spektrum der Wissenschaft,由大众科学设计

Transformer 可以掌握这项具有挑战性的任务:它们将单词转换为特别合适的数学表示形式。但这需要大量工作。开发人员必须向网络提供大量文本,以便它学习哪些单词出现在相似的环境中,从而在语义上相似。

一切都与注意力有关

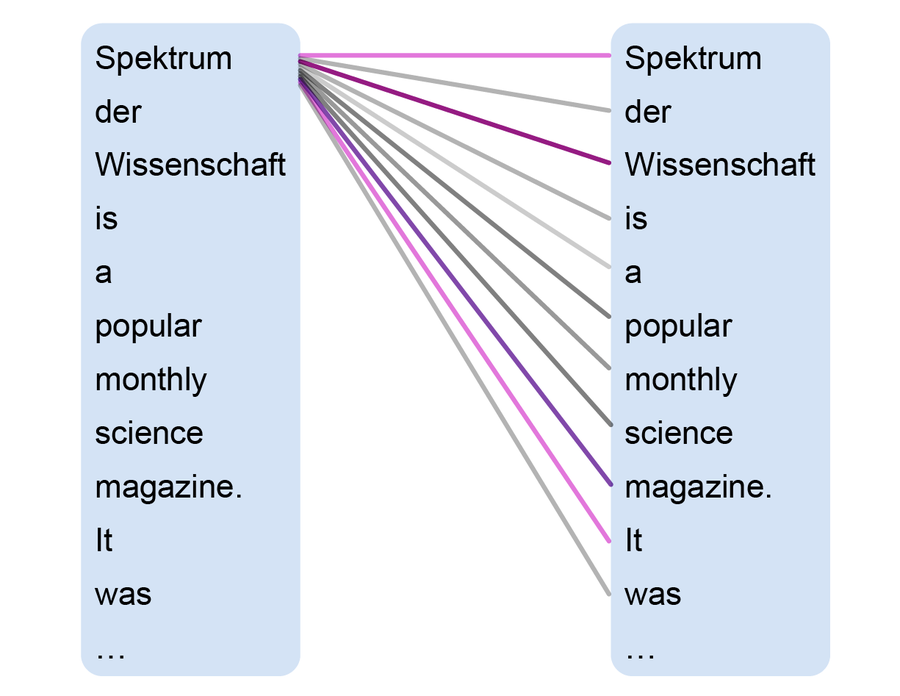

但仅此一项还不够。您还必须确保人工智能在训练后能够理解更长的输入。例如,以德语维基百科条目中关于 Spektrum der Wissenschaft 的第一行文字为例。它们大致翻译为“Spektrum der Wissenschaft 是一本受欢迎的月度科学杂志。它成立于 1978 年,是《大众科学》的德语版,自 1845 年以来一直在美国出版,但随着时间的推移,它在美国原版的基础上变得越来越独立。” 语言模型如何知道第二句中的“美国”和“原版”指的是什么?过去,大多数神经网络都无法完成此类任务——直到 2017 年,谷歌大脑的专家引入了一种新型的网络架构,该架构完全基于所谓的注意力机制,它是 Transformer 网络的核心。

注意力使人工智能模型能够识别输入中最重要的信息:哪些词是相关的?哪些内容与输出最相关?因此,人工智能模型能够识别文本中相距较远的词语之间的引用。为此,注意力会获取句子中的每个单词,并将其与其他每个单词关联起来。因此,对于维基百科示例中的句子,模型从“Spektrum”开始,并将其与条目中的所有其他单词进行比较,包括“是”、“科学”等等。此过程允许找到输入单词的新数学表示形式——并且考虑到句子的内容。这种注意力步骤发生在训练期间和用户键入内容时的操作中。

人工智能模型中注意力机制的图示。 来源:Manon Bischoff/Spektrum der Wissenschaft,由大众科学设计

这就是 ChatGPT 或 Luminous 等语言模型如何处理输入并从中生成响应的方式。通过确定要注意哪些内容,程序可以计算出哪些词最有可能跟随输入。

有针对性地转移焦点

这种注意力机制可用于使语言模型更加透明。AtMan 以“注意力操纵”的思想命名,专门操纵人工智能对某些输入词的关注程度。它可以将注意力 направлять 向某些内容,并从其他内容上移开。这使得人们可以查看输入的哪些部分对输出至关重要,而又不会消耗过多的计算能力。

例如,研究人员可以将以下文本传递给语言模型:“你好,我叫卢卡斯。我喜欢足球和数学。我过去几年一直在研究……” 模型最初通过用“我的计算机科学学位”填空来完成这个句子。当研究人员告诉模型增加对“足球”的关注时,输出变为“足球场”。当他们增加对“数学”的关注时,他们得到了“数学和科学”。

因此,AtMan 代表了 XAI 领域的重要进步,可以使我们更接近理解人工智能系统。但它仍然无法将语言模型从疯狂的幻觉中拯救出来——也无法解释为什么 ChatGPT 认为弗洛里安·弗赖斯特特是 Spektrum der Wissenschaft 的主编。

然而,它至少可以用来控制人工智能考虑和不考虑哪些内容。施拉莫夫斯基解释说:“例如,这在评估个人信用度的算法中很重要。“如果程序将其结果建立在诸如个人肤色、性别或出身等敏感数据之上,您可以专门关闭对该数据的关注。” 如果 AtMan 揭示人工智能程序的输出受到传递给它的内容的影响极小,那么 AtMan 也可以提出问题。在这种情况下,人工智能显然是从训练数据中获取了其所有生成的内容。“那时您应该彻底检查结果,”施拉莫夫斯基说。

AtMan 不仅可以以这种方式处理文本数据,还可以处理 Transformer 模型可以处理的任何类型的数据。例如,该算法可以与提供图像描述的人工智能相结合。这可以用于找出图像的哪些区域导致了所提供的描述。在他们的出版物中,研究人员查看了一张熊猫的照片——发现人工智能主要根据动物的脸部来描述“熊猫”。

“而且 AtMan 似乎可以做更多的事情,”也帮助开发该算法的戴泽罗斯说。“您可以专门使用 AtMan 的解释来改进人工智能模型。” 过去的工作已经表明,较小的人工智能系统在经过训练以提供良好的推理时会产生更好的结果。现在仍有待研究的是,AtMan 和大型 Transformer 模型是否也是如此。“但这仍然需要检查,”戴泽罗斯说。

本文最初发表在《Spektrum der Wissenschaft》杂志上,并经许可转载。