如果你曾经对人类感到愤世嫉俗,那么与人工智能研究人员交谈是一个很好的解药。你可能会期望他们现在会洋洋得意,因为人工智能系统在识别面孔、翻译语言、玩棋盘和街机游戏以及记住使用转向灯方面与人类匹敌甚至超越人类。恰恰相反,他们总是谈论人类大脑是多么奇妙,多么适应性强,多么高效,多么具有无限的能力。机器仍然缺乏这些品质。它们不灵活、不透明且学习缓慢,需要大量的训练。即使是他们广为人知的成功也只是非常狭隘的。

许多人工智能研究人员进入这个领域是因为他们想要理解、复制并最终超越人类智能。然而,即使是那些对实际应用更感兴趣的人也认为机器系统应该更像我们。例如,一家社交媒体公司训练其图像识别器,可以毫不费力地找到猫或名人的照片。但是其他类别的数据更难获得,如果机器更机智,它们可以解决更广泛的问题。如果数据涉及物理世界,则数据尤其有限。如果机器人必须学习操纵桌子上的积木,它不可能实际地被展示它可能遇到的每一种排列。像人类一样,它需要掌握通用技能,而不是死记硬背。

在以更少的输入来维持运转的同时,机器还需要更充分地输出。仅仅是答案是不够的;人们还想知道推理过程,尤其是在算法对银行贷款或刑期做出判断时。你可以质问人类官僚他们的偏见和利益冲突;祝你好运,用今天的 AI 系统做到这一点。2018 年,欧盟赋予其公民有限的权利,要求对自动化处理做出的任何判断做出解释。在美国,国防高级研究计划局资助了一个“可解释的 AI”研究计划,因为军事指挥官宁愿在不知道原因的情况下不派遣士兵投入战斗。

支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保关于塑造我们今天世界的发现和想法的具有影响力的故事的未来。

一个庞大的研究团体正在解决这些问题。想法层出不穷,人们争论更像人类的智能是否需要彻底的改造。然而,研究人员通过相当渐进的改进走了多远,这令人瞩目。自我完善、想象力、常识:这些看似典型的特质正在被融入机器中,至少在有限的程度上是这样。关键在于巧妙的指导。在人类训练员的指导下,机器本身迈出了最大的步伐。

深度网络

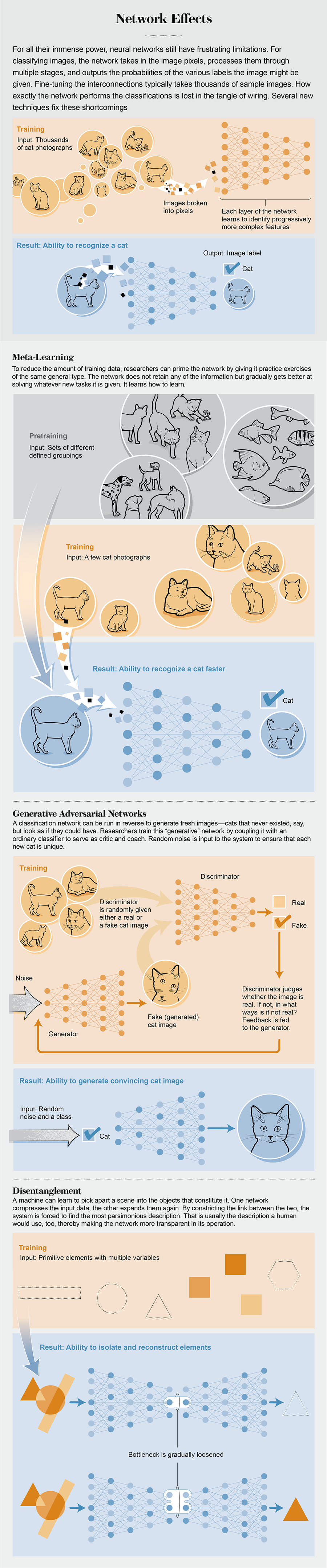

与大多数科学和工程领域相比,人工智能具有高度周期性。它经历了狂热和忽视的浪潮,方法也随之兴衰。神经网络是新兴的技术。这种网络是由基本计算单元组成的网络:“神经元”。每个神经元都可以像一个开关一样简单,根据与其连接的神经元的状态而打开或关闭。神经元通常以层排列。初始层接受输入(例如图像像素),最终层产生输出(例如图像内容的高级描述),中间层或“隐藏”层创建输入的算术组合。一些网络,特别是那些用于随时间展开的问题(例如语言识别)的网络,具有将输出或隐藏层重新连接到输入的循环。

所谓的深度网络有数十甚至数百个隐藏层。它们可能代表中级结构,例如边缘和几何形状,尽管它们在做什么并不总是显而易见的。凭借数千个神经元和数百万个互连,系统中没有简单的逻辑路径。而这正是设计目的。神经网络是解决不适合显式逻辑规则的问题(例如模式识别)的大师。

至关重要的是,神经元连接不是预先固定的,而是在试错过程中适应的。你向网络输入标记为“狗”或“猫”的图像。对于每个图像,它猜测一个标签。如果它错了,你调整导致错误结果的连接强度,这是一个直接的微积分练习。从完全从头开始,不知道什么是图像,更不用说动物了,网络的表现与抛硬币没什么两样。但在可能经过 10,000 个示例后,它的表现与呈现相同图像的人类一样好。在其他训练方法中,网络响应更模糊的提示,甚至完全自行辨别类别。

值得注意的是,网络可以对它从未见过的图像进行排序。理论家们仍然不太确定它是如何做到的,但一个因素是,使用网络的人类必须容忍错误,甚至故意引入错误。一个完美地分类其初始批次的猫和狗的网络可能是在弄虚作假:将其判断建立在不可靠的线索和变化上,而不是基本特征上。

网络塑造自身的能力意味着它们可以解决其人类设计者不知道如何解决的问题。这包括使网络在它们所做的事情上做得更好的问题。

图片来源:Brown Bird Design

走向元学习

老师们经常抱怨学生在暑假期间会忘记一切。他们没有缩短假期,而是给他们布置了大量的暑假作业。但是加州大学洛杉矶分校的罗伯特·比约克等心理学家发现,遗忘对于学习来说并非有害,而是必不可少的。这个原则也适用于机器学习。

如果一台机器学习一项任务,然后忘记它,然后学习另一项任务并忘记它,依此类推,它可以被指导掌握这些任务的共同特征,并且它将更快地掌握新的变体。它不会学到任何具体的东西,但它会学到如何学习——研究人员称之为元学习。当你确实希望它保留信息时,它会做好准备。“在你学会做 1,000 项任务后,第 1,001 项任务就容易得多,”普林斯顿大学的机器学习理论家 Sanjeev Arora 说。遗忘是将元学习中的“元”字放入其中的原因。没有它,所有任务都模糊在一起,机器无法看到它们的整体结构。

元学习赋予机器我们的一些思维敏捷性。“它可能是实现能够以人类水平智能执行任务的 AI 的关键,”谷歌 DeepMind 伦敦分部的计算神经科学家 Jane Wang 说。相反,她认为计算机元学习将帮助科学家弄清楚我们自己大脑内部发生了什么。

在自然界中,终极的元学习算法是达尔文进化论。在变化的环境中,物种被驱动发展学习能力,而不是仅仅依靠固定的本能。在 20 世纪 80 年代,人工智能研究人员使用模拟进化来优化软件代理的学习。但是进化是一种随机搜索,会走许多死胡同,在 21 世纪初,研究人员找到了更系统化、因此更快速的方法。事实上,通过正确的训练方案,任何神经网络都可以学会学习。与机器学习中的许多其他方面一样,诀窍在于非常具体地说明你想要什么。如果你想让网络学习面孔,你应该向它展示一系列面孔。以此类推,如果你想让网络学习如何学习,你应该向它展示一系列学习练习。

2017 年,加州大学伯克利分校的切尔西·芬恩和她的同事开发了一种他们称为模型无关元学习的方法。假设你想教你的神经网络将图像分类为五个类别之一,无论是犬种、猫种、汽车品牌、帽子颜色,还是其他什么。在正常的学习中,没有“元学习”,你输入数千张狗的图像并调整网络来对它们进行排序。然后你输入数千张猫的图像。这有一个不幸的副作用,即会覆盖狗;以这种方式教导,机器一次只能执行一项分类任务。

在模型无关元学习中,你交错类别。你向网络展示仅仅五张狗的图像,每种犬种一张。然后你给它一张测试图像,看看它对那只狗的分类效果如何——在五个例子之后可能不会很好。你将网络重置到它的起点,清除它可能获得的关于狗的任何微薄的知识。但是——这是关键步骤——你调整这个起点,以便下次做得更好。你切换到猫——同样,每种品种只有一个样本。你继续进行汽车、帽子等等,在它们之间随机循环。轮换任务并经常测验。

网络没有掌握狗、猫、汽车或帽子,而是逐渐学习了初始状态,这使得它在对任何以五为单位输入的东西进行分类时都能获得最佳的先发优势。到最后,它是一个快速学习者。你可能会给它看五种鸟类:它马上就能识别出来。

芬恩说,网络通过发展一种偏见来实现这种敏锐度,在这种情况下,这是一种好事。它期望其输入数据采用图像的形式,并据此做好准备。“如果你有一个能够挑选出物体的形状、物体的颜色和纹理,并能够以非常简洁的方式表示它们,那么当你看到一个新物体时,你应该能够非常快速地识别它,”她说。

芬恩和她的同事还将他们的技术应用于真实和虚拟机器人。在一个实验中,他们给一个四足机器人一系列任务,让它向各个方向奔跑。通过元学习,机器人推断出这些任务的共同特征是奔跑,唯一的问题是:朝哪个方向?因此,机器通过原地跑步来做好准备。“如果你在原地跑步,那么将自己快速调整为向前跑或向后跑会更容易,因为你已经在跑步了,”芬恩说。

这项技术,以及王和其他人提出的相关方法,确实有其局限性。尽管它减少了给定任务所需的样本数据量,但总体上仍然需要大量数据。“当前的元学习方法需要大量的背景训练,”纽约大学的认知科学家布伦丹·莱克说,他已成为更像人类的 AI 的主要倡导者。元学习在计算方面也很苛刻,因为它利用了任务之间可能非常细微的差异。如果问题在数学上没有得到充分的定义,研究人员必须回到较慢的进化算法。“神经网络已经取得了进展,但仍然远未实现像人类概念学习那样的水平,”莱克说。

从未存在的事物

互联网最需要的东西:更多名人照片。在过去几年中,一种新的、奇怪的品种的照片充斥着网络:从未真正存在过的人的照片。它们是一种具有敏锐想象力的新型 AI 技术的产物。“它试图想象看起来可能在我们社会中成为名人的新人的照片,”加利福尼亚州山景城谷歌大脑的伊恩·J·古德费洛说。“你会得到这些非常逼真的、传统上具有吸引力的人的照片。”

想象力很容易自动化。你基本上可以采用图像识别或“判别式”神经网络并反向运行它,然后它就变成图像生成或“生成式”网络。判别器在给定数据的情况下,返回一个标签,例如犬种。生成器在给定标签的情况下,返回数据。困难的部分是确保数据有意义。如果你输入“西施犬”,网络应该返回一个典型的西施犬。如果它要按需生成一只狗,它需要发展出狗的内置概念。调整网络以做到这一点在计算上具有挑战性。

2014 年,当时正在完成博士学位的古德费洛突然想到将两种类型的网络结合起来。生成器创建图像,判别器将其与数据进行比较,判别器的吹毛求疵会指导生成器。“我们在两个玩家之间建立了一个游戏,”古德费洛说。“其中一个是生成器网络,它创建图像,另一个是判别器网络,它查看图像并尝试猜测它们是真实的还是伪造的。”该技术被称为生成对抗网络。

最初,生成器产生随机噪声——显然不是任何东西的图像,更不用说训练数据了。但判别器在最初阶段并没有很强的辨别力。随着它改进自己的品味,生成器不得不提高自己的水平。因此,两者相互促进。在艺术家战胜评论家的胜利中,生成器最终以足够的逼真度再现数据,以至于判别器沦为随机猜测其输出是真实的还是伪造的。

这个过程很繁琐,网络可能会陷入创建不真实的图像或未能捕捉到数据的全部多样性。例如,生成器为了尽可能少地欺骗判别器,可能会始终将面孔放置在相同的粉红色背景上。“我们没有一个伟大的数学理论来解释为什么有些模型仍然表现良好,而另一些模型表现不佳,”古德费洛说。

尽管如此,在 AI 中很少有其他技术能如此迅速地找到如此多的用途,从分析宇宙学数据到设计牙冠。每当你需要吸收数据集并生成具有相同统计数据的模拟数据时,你都可以求助于生成对抗网络。“你只需给它一大堆图片,然后你说,‘你能给我制作一些像它们一样的图片吗?’”纽约大学的物理学家凯尔·克兰默说,他使用该技术来模拟粒子碰撞,速度比求解所有量子方程更快。

最引人注目的应用之一是 Pix2Pix,它可以完成几乎任何你能想到的图像处理类型。例如,像 Photoshop 这样的图形应用程序可以轻松地将彩色图像简化为灰度图像,甚至简化为线条图。反过来则需要更多的工作——为图像着色或绘画需要做出创造性的选择。但是 Pix2Pix 可以做到这一点。你给它一些彩色图像和线条图的样本对,它就会学习将两者联系起来。在这一点上,你可以给它一个线条图,它会填充一个图像,即使对于你最初没有训练它的东西也是如此。

其他项目用合作代替竞争。2017 年,东京地球生命科学研究所的尼古拉斯·古滕贝格和奥拉夫·维特科夫斯基建立了一对网络,并向它们展示了他们用各种艺术风格创作的一些迷你画作。网络必须确定风格,但转折点在于每个网络都看到了艺术品的不同部分。因此,他们必须协同工作,为了做到这一点,他们必须发展一种私有语言——一种简单的语言,这是肯定的,但对于手头的任务来说已经足够有表现力了。“他们会找到一套共同讨论的事情,”古滕贝格说。

自学交流的网络开辟了新的可能性。“希望看到一个网络社会发展语言并相互传授技能,”古滕贝格说。如果一个网络可以向另一个同类网络传达它在做什么,那么它也许可以学会向人类解释自己,使其推理过程不那么神秘。

学习常识

人工智能会议中最有趣的部分是研究人员展示神经网络犯下的愚蠢错误,例如将随机静态误认为犰狳,或将校车误认为鸵鸟。它们的知识显然非常肤浅。它们辨别的模式可能与构成场景的物理对象无关。“它们缺乏扎实的构成对象理解,即使是像老鼠这样的动物也具备这种理解,”DeepMind 的人工智能研究员伊琳娜·希金斯说。

2009 年,蒙特利尔大学的约书亚·本吉奥提出,如果神经网络的内部表示可以解开——也就是说,如果它们的每个变量都对应于世界的某个独立特征——神经网络将获得一些真正的理解。例如,网络应该为每个对象都有一个位置变量。如果一个对象移动,但其他一切都保持不变,那么只有这一个变量应该改变,即使在其身后改变了数百或数千个像素。

2016 年,希金斯和她的同事设计了一种实现这一目标的方法。它的工作原理是,真实的变量集——与世界的实际结构对齐的集合——也是最经济的。图像的数百万像素是由相对较少的变量以多种方式组合生成的。“世界具有冗余性——这是大脑可以压缩和利用的那种冗余性,”希金斯说。为了获得简洁的描述,她的技术做了相当于眯眼的计算——故意限制网络表示世界的能力,因此它被迫只选择最重要的因素。她逐渐放松限制,并允许它包括次要因素。

在一个演示中,希金斯和她的同事构建了一个简单的“世界”供网络剖析。它由网格上的心形、正方形和椭圆形组成。每个形状可以是六种不同尺寸之一,并以 20 个不同角度之一定向。研究人员将所有这些排列方式呈现给网络,其目标是隔离五个潜在因素:形状、沿两个轴的位置、方向和大小。起初,他们只允许网络使用一个因素。它选择位置作为最重要的因素,没有这个变量,其他任何变量都毫无意义。随后,网络添加了其他因素。

可以肯定的是,在这个演示中,研究人员知道这个世界的规则,因为他们自己创造了这个世界。在现实生活中,解耦是否有效可能并不那么明显。目前,这种评估仍然需要人类的主观判断。

像元学习和生成对抗网络一样,解耦有很多应用。首先,它使神经网络更易于理解。你可以直接看到它们的推理过程,而且它与人类的推理过程非常相似。机器人还可以使用解耦来绘制其环境地图并规划其移动,而不是通过反复试验来摸索。结合研究人员称之为内在动机——本质上是好奇心——解耦引导机器人系统地探索。

此外,解耦有助于网络学习新的数据集,而不会丢失它们已经知道的东西。例如,假设你向网络展示狗。它将开发一种特定于犬种的解耦表示。如果你切换到猫,新图像将超出该表示的范围——胡须的类型将是一个泄露——网络将注意到这种变化。“我们实际上可以观察神经元是如何响应的,如果它们开始表现异常,那么我们可能应该开始学习关于新数据集的知识,”希金斯说。在这一点上,网络可能会通过例如添加额外的神经元来存储新信息来适应,这样它就不会覆盖旧信息。

人工智能研究人员赋予其机器的许多品质在人类中都与意识有关。没有人确定意识是什么或我们为什么会有生动的精神生活,但它与我们构建世界和我们自己的模型的能力有关。人工智能系统也需要这种能力。有意识的机器似乎还很遥远,但今天的技术会不会是走向有意识机器的婴儿学步呢?