使用光而不是电来构建计算机的想法可以追溯到半个多世纪以前。“光学计算”长期以来一直承诺比传统电子计算机更快地执行计算,同时消耗更少的能量。然而,由于科学家们一直在努力制造出能够超越现有计算机的光基组件,因此,实际光学计算机的前景一直不被看好。尽管遇到了这些挫折,光学计算机现在可能会有一个新的开始——研究人员正在测试一种新型的光子计算机芯片,它可以为像自动驾驶汽车一样智能,但小到可以放入口袋的人工智能设备铺平道路。

传统计算机依赖于电子电路,这些电路相互打开和关闭,以仔细编排的方式对应于,例如,两个数字的乘法。光学计算遵循类似的原理,但不是电子流,而是由光子束执行计算,光子束彼此相互作用,并与透镜和分束器等引导组件相互作用。与必须在电阻的潮流中流经电路的曲折的电子不同,光子没有质量,以光速传播,并且一旦产生,就不会消耗额外的能量。

麻省理工学院的研究人员在《自然光子学》杂志上发表文章,最近提出,基于光学的计算将特别有助于增强深度学习,深度学习是人工智能近期许多进展的基础技术。深度学习需要大量的计算:它需要将大量数据集输入到基于人脑神经结构的大型模拟人工“神经元”网络中。每个人工神经元接收一系列数字,对这些输入执行简单的计算,并将结果发送到下一层神经元。通过调整每个神经元执行的计算,人工神经网络可以学习执行各种各样的任务,例如识别猫和驾驶汽车。

关于支持科学新闻

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保有关塑造我们当今世界的发现和想法的具有影响力的故事的未来。

深度困境

深度学习已经成为人工智能的核心,包括谷歌和高性能芯片制造商英伟达在内的公司已经投入数百万美元开发专门用于深度学习的芯片。这些芯片利用了人工神经网络的大部分时间都花在“矩阵乘法”上的事实——矩阵乘法是指每个神经元对其输入求和的操作,每个输入都有不同的值。例如,在面部识别神经网络中,一些神经元可能正在寻找鼻子的迹象。这些神经元会给对应于小的、黑暗区域(可能是鼻孔)的输入赋予更大的值,给光斑(可能是皮肤)赋予略低的值,而给霓虹绿色(极不可能装饰某人的鼻子)赋予非常小的值。一种专门的深度学习芯片通过将这些加权总和分配到芯片的数百个小型独立处理器中,同时执行许多这些加权总和,从而显著加快了速度。

这种类型的工作负载需要相当于一台小型超级计算机的处理能力。奥迪和其他制造自动驾驶汽车的公司有奢侈的时间将整排计算机塞进后备箱,但要想将这种处理能力装入人工智能无人机或手机中,那就祝你好运了。即使神经网络可以在大型服务器场上运行,例如谷歌翻译或 Facebook 的面部识别,这种重型计算也会产生数百万美元的电费。

2015 年,麻省理工学院的博士后研究员,同时也是这篇新论文的主要作者沈逸辰(音译)正在寻找一种新的深度学习方法,以解决这些功率和尺寸问题。他偶然发现了共同作者尼古拉斯·哈里斯(Nicholas Harris)的工作,后者是麻省理工学院电气工程和计算机科学专业的博士生,他构建了一种新型的光学计算芯片。尽管之前的大多数光学计算机都失败了,但沈逸辰意识到,可以将光学芯片与传统计算机混合使用,为深度学习开辟新的前景。

杂交计算机

许多研究人员早就放弃了光学计算。从 20 世纪 60 年代起,贝尔实验室和其他公司花费了大量资金设计光学计算机部件,但最终他们的努力几乎没有带来任何好处。“光学等效电子晶体管从未被开发出来,”上阿尔萨斯大学光学计算教授皮埃尔·安布斯说,并且光束无法执行基本的逻辑运算。

然而,与之前的大多数光学计算机不同,哈里斯的新芯片并没有试图取代传统的 CPU(中央处理单元)。它旨在仅为量子计算执行专门的计算,量子计算利用亚原子粒子的量子态来比传统计算机更快地执行某些计算。当沈逸辰参加哈里斯关于新芯片的演讲时,他注意到量子计算与阻碍深度学习的矩阵乘法相同。他意识到深度学习可能是几十年来光学计算一直无法实现的“杀手级应用”。受到启发,麻省理工学院的团队将哈里斯的光子芯片连接到一台普通计算机,允许深度学习程序将其矩阵乘法卸载到光学硬件。

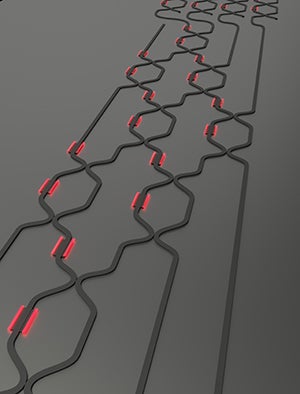

图片来源:尼古拉斯·哈里斯

当他们的计算机需要进行矩阵乘法(即,对一些数字进行一堆加权求和)时,它首先将这些数字转换为光学信号,较大的数字表示为更亮的光束。然后,光学芯片将整个乘法问题分解为许多较小的乘法,每个乘法由芯片的单个“单元”处理。要理解单元的操作,请想象有两条水流流入其中(输入光束),两条水流流出。该单元的作用类似于闸门和泵的晶格——分割水流,加速或减速,并将它们混合在一起。通过控制泵的速度,单元可以将不同量的水引导到每个输出水流。

泵的光学等效物是加热的硅通道。哈里斯解释说,当加热时,“[硅]原子会稍微扩散开,这会导致光以不同的速度传播”,从而导致光波相互增强或抑制,就像声波一样。(抑制后者是降噪耳机的工作原理。)传统的计算机设置加热器,使得每个单元的输出通道中流出的光量是输入的加权总和,加热器决定权重。

要有光?

沈逸辰和哈里斯通过训练一个简单的神经网络来识别不同的元音来测试他们的芯片。结果平平,但沈逸辰将其归因于重新利用了不完全合适的设备。例如,用于将数字转换为光学信号和从光学信号转换为数字的组件是粗略的概念证明,之所以选择它们仅仅是因为它们很容易连接到哈里斯的量子计算芯片。根据他们在《自然光子学》杂志上的论文,专门为深度学习制造的更完善的计算机版本可以提供与最佳传统芯片相同的精度,同时将能耗降低几个数量级,并提供 100 倍的速度。这将使即使是手持设备也能内置人工智能功能,而无需将繁重的工作外包给大型服务器,否则这将几乎是不可能的。

当然,光学计算的坎坷历史为持怀疑态度留下了充足的空间。“我们不应该过于兴奋,”安布斯警告说。沈逸辰和哈里斯的团队尚未展示完整的系统,安布斯的经验表明,有时“很难如此大幅度地改进基本系统”。

尽管如此,即使安布斯也认为这项工作“与 90 年代的 [光学] 处理器相比取得了巨大进步”。沈逸辰和哈里斯也很乐观。他们正在创办一家初创公司以将他们的技术商业化,并且他们相信更大的深度学习芯片会起作用。哈里斯认为,他们将当前芯片的错误归咎于的所有因素都有已知的解决方案,因此“这只是一个让合适的人参与并实际构建它的工程挑战”。