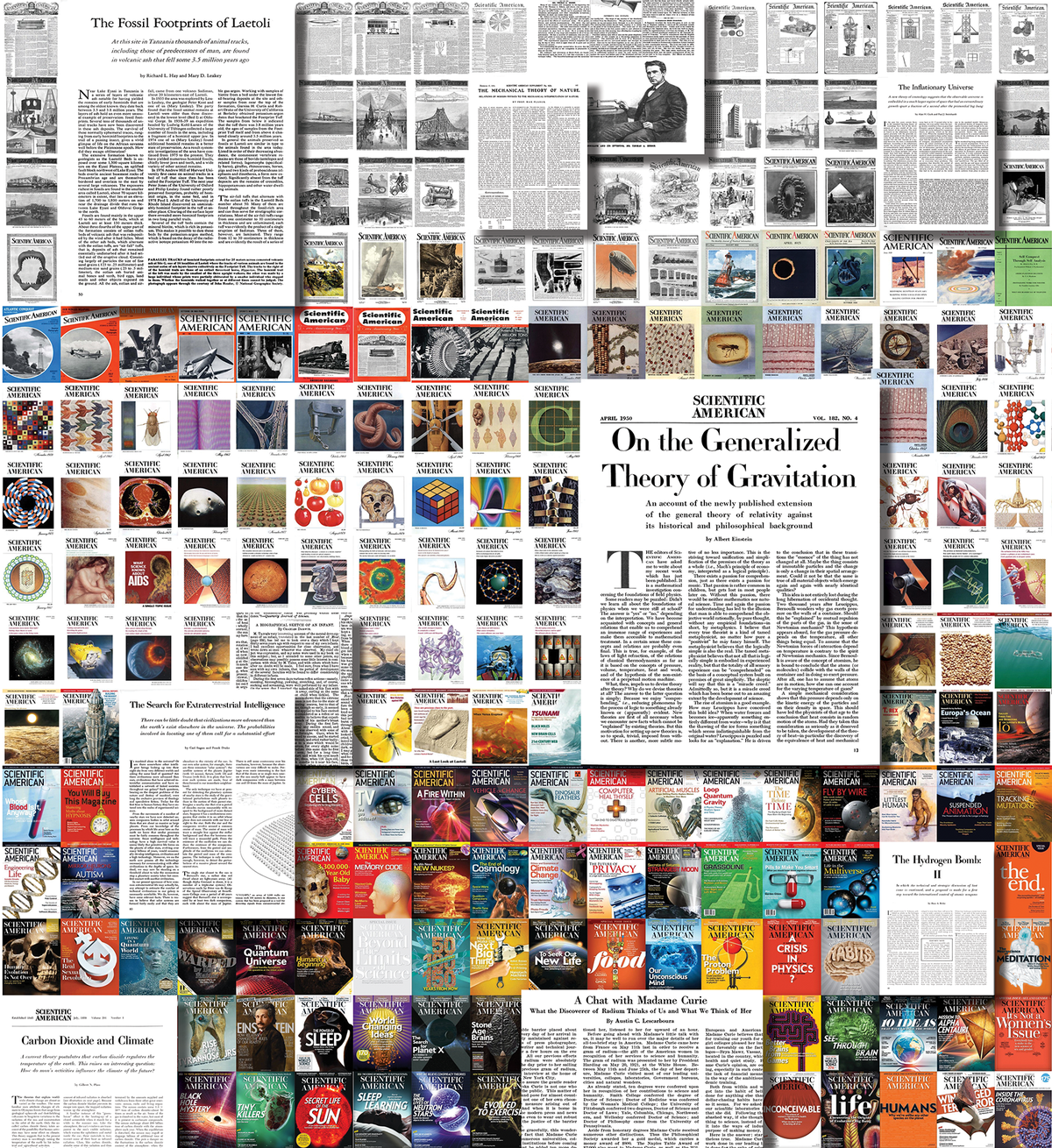

将一本拥有175年历史的杂志——即5107期,199,694页,包含110,292,327个单词!——的历史总结成一系列图形,这是一项艰巨的任务。当装有64GB .pdf文件的硬盘驱动器送到我在德国的家中时,我很好奇地想深入研究,但也有些害怕:作为一名具有认知科学背景的数据可视化顾问,我非常清楚,语言的细微之处及其语义内容只能通过计算方法来近似。

我喜欢从集思广益概念想法和数据发现问题开始,并将自己沉浸在可用的材料中。为了获得灵感,我阅读了杂志跨越数十年的样本,惊叹于古老的插图和字体。我早期建立了一个数据预处理管道,从.pdf文件中提取文本并运行首次分析。我使用了 Jupyter Notebooks(一个用于数据探索的灵活编程环境),以及 spaCy Python 库(它使用计算语言学将单纯的字符序列转化为语言的结构化表示)和 pandas 包(一个用于轻松快速处理大量数值数据的工具包)。

任何数据科学项目的核心问题在于对数据集撒网的范围有多大。如果网太粗,所有有趣的小鱼都可能逃脱。然而,如果网太细,最终可能会得到很多碎片,而且过多的细节会掩盖大局。我们能否找到一种简单但有趣且真实的方法,将大量数据提炼成易于理解的形式?编辑和我探索了许多概念想法:查看句子长度、特定词语的首次出现、标点符号风格的变化(问号会增加吗?),以及提及的人物和地点。这些方法中的任何一种都能得到可用数据的支持吗?

关于支持科学新闻

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道: 订阅。通过购买订阅,您正在帮助确保未来能够继续讲述关于塑造我们当今世界的发现和思想的有影响力的故事。

很快就变得明显,来自《大众科学》(1993年之前)前数字时代的任何文本都在一定程度上受到光学字符识别(OCR)错误的影响。从图像中重建原始文本是一个天生嘈杂的过程,其中字母可能会混淆(例如,“substantially”经常被解析为“snbstantlally”),单词可能会在错误的位置组合或拆分,或者多列布局可能会以错误的顺序读取。因此,将数据分析镜头拉远到年度视角(而不是在单个版本的层面上工作)并分析单个单词的计数(而不是寻找复合词或进行句子级分析)成为我们在准确性和抗噪声鲁棒性之间权衡空间中的最佳点。

我的第一直觉是关注“写了什么”,但在处理数据时,我对关注“如何”变得特别感兴趣:动词、形容词和副词的演变。这些词类可以说明原始杂志的基调和态度是如何从工程驱动的机械语言转变为我们今天所知的多方面的科学杂志的。

另一个关键的见解是了解到英语中使用的词汇实际上种类很少。鉴于语言中(以及《大众科学》文本档案库中)单词的频率如此倾斜,与其比较单词出现的原始数字,不如关注单词每年占据的文本比例(其相对频率)如何随时间演变,这变得更有说服力。

基于这个中心思想,我们探索了许多不同的视觉形式——词云、堆积面积图、折线图、动画、语义空间的空间地图——最终确定使用分层堆积面积图作为开篇跨页的概览可视化。这种对词汇主要变化的宏观视图,以“沉积层”的形式展示,并辅以显示每年每个峰值词演变的单个微型折线图。

为了使密集的图表排列易于扫描,需要有意识的视觉设计选择。用连续的色阶来强化折线图的形状可能看起来是多余的装饰,但它在感知上非常有效,因为它允许我们快速查看一个词是“旧的”还是“新的”,而无需详细研究线条形状。此外,颜色关联(灰色/棕色代表机械的、复古的过去,而清新的现代紫色代表现在)有助于将数据语义和视觉形式联系在一起。

进行数据科学意味着必须接受不完美。没有模型可以完全再现现实,而且有些数据对我来说仍然是神秘的。例如:为什么“substantially”的使用在 1868 年之后大幅下降?(我怀疑是与新字体相关的 OCR 错误。)其他问题是调查的起点:为什么“tomato”在 1978 年达到峰值?每一个新的发现都会激发好奇心,我鼓励其他人将这个数据集视为新问题的灵感,而不是客观和最终的衡量标准。

在 www.scientificamerican.com/interactive/science-words 亲自探索数据