杀人机器即将到来。无需人类监督即可瞄准和摧毁目标的机器人武器,势必会引发一场堪比火药或原子弹发明的战争革命。这种前景对平民构成了可怕的威胁,并可能导致人工智能失控的一些最黯淡的局面。 迫切需要禁止杀人机器人,类似于禁止化学和生物武器。但一些主要的军事强国反对这样做。

机器人绝非技术恐惧症的幻想。 例如,2017年7月,俄罗斯卡拉什尼科夫集团宣布,它已开始研制配备摄像头的7.62毫米机枪,该机枪使用神经网络来做出“射击/不射击”的决定。 包括无人机、舰船和坦克在内的整整一代自主控制武器,正朝着不同程度的自主运行发展。 美国似乎在自主系统研发方面处于领先地位,从2016年到2020年,计划投资180亿美元。 但其他拥有强大军工业的国家也在进行自己的投资。

军事规划人员认为,“致命自主武器系统”——一个更委婉的术语——理论上可以为战争带来超然的精确性。 这种自动装置可以减少对军队的需求,并通过让机器自行战斗来减少伤亡。 然而,算法控制可能会演变成“失控”。 现有的人工智能无法推断他人的意图,也无法在混乱的战争中通过概括过去的经验来做出关键决策。 在可预见的未来任务中,人工智能是否应该取代美国大兵,这应该受到质疑,因为人工智能无法解读行为的细微之处来区分平民和战斗人员,或友军和敌军。 任何类型的杀人机器人都会是训练有素的刺客,就像《终结者》中的阿诺德·施瓦辛格一样。 此外,战斗结束后,当机器进行杀戮时,谁将承担责任? 机器人? 它的主人? 它的制造者?

支持科学新闻事业

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻事业 订阅。 通过购买订阅,您正在帮助确保有关当今塑造我们世界的发现和想法的具有影响力的故事的未来。

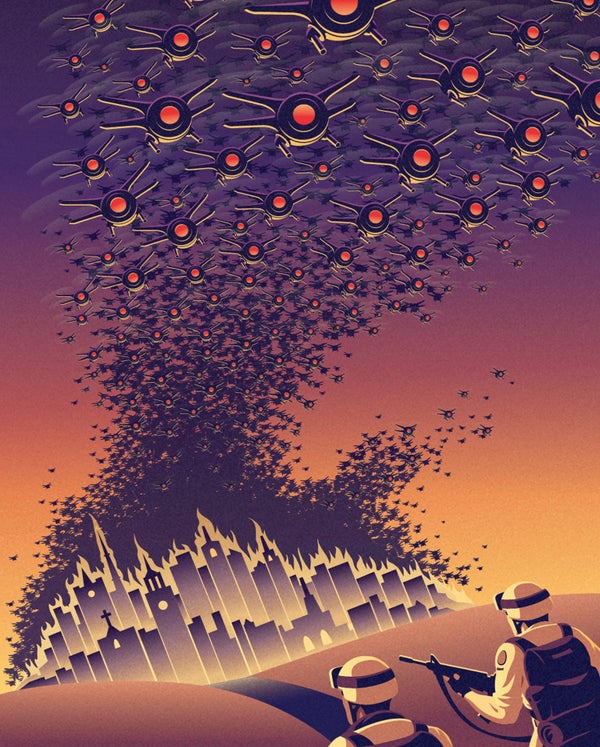

考虑到所有这些缺点,使用近期技术制造的完全自主机器人可能会对专业知识或财政资源匮乏的小国或恐怖分子构成新的威胁。 成群结队的小型武器化无人机,甚至可能是使用3D打印机制造的,可能会在人口稠密地区造成严重破坏。 原型机已经在测试中:美国国防部在2016年演示了超过100架微型无人机的非武器化蜂群。 加州大学伯克利分校的人工智能研究领域的杰出人物斯图尔特·罗素认为,仅仅一个人部署的“杀伤人员微型机器人”就可能杀死数千人,并构成潜在的大规模杀伤性武器。

自2013年以来,《联合国特定常规武器公约》(CCW)一直在讨论如何处理致命自主武器系统,该公约 регулирует 燃烧装置、致盲激光和其他被认为危害过大的武器。 由于美国、俄罗斯和少数其他国家的反对,讨论尚未进入起草正式禁令语言的阶段。 例如,美国辩称,其政策已经规定军事人员保留对自主武器的控制权,并且过早的监管可能会抑制至关重要的人工智能研究。

禁令不必过于严格。 “停止杀人机器人运动”是一个由来自50个国家的89个非政府组织组成的联盟,该联盟一直呼吁禁止这种武器,它强调禁令将仅限于进攻性武器,而不扩展到反导和其他自动发射以应对来袭弹头的防御系统。

当前的僵局促使该运动考虑争取至少一些国家在《特定常规武器公约》提供的论坛之外同意禁令,这是以前使用过的一种选择,以启动禁止地雷和集束弹药的国际协议。 抢先禁止自主杀人机器,并制定明确的合规要求,将使这项技术蒙上污名,并有助于将杀人机器人排除在军事武库之外。

自从首次在7月于斯德哥尔摩举行的国际人工智能联合会议上提出以来,已有244个组织和3,187名个人签署了一项承诺书,承诺“既不参与也不支持致命自主武器的开发、制造、贸易或使用”。 做出这样承诺的理由是,禁止杀人机器人的法律尚未通过。 如果没有这样的法律框架,算法可能很快就会做出夺走人类生命的致命决定。