2014年,SpaceX 首席执行官埃隆·马斯克发推文说:“值得阅读博斯特罗姆的《超级智能》。我们需要对人工智能超级小心。可能比核武器更危险。” 同年,剑桥大学宇宙学家斯蒂芬·霍金告诉 BBC:“全面人工智能的发展可能意味着人类的终结。” 微软联合创始人比尔·盖茨也警告说:“我属于担心超级智能阵营。”

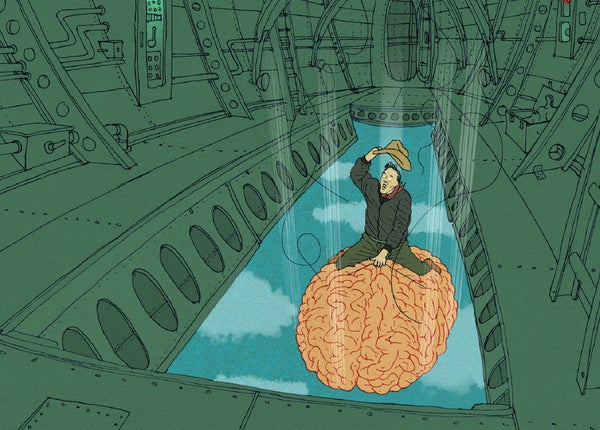

计算机科学家埃利泽·尤德科夫斯基在 2008 年出版的《全球灾难性风险》一书中概述了人工智能末日可能如何展开:“人工智能从变形虫跨越到乡村白痴的整个巨大鸿沟的可能性有多大,然后停留在人类天才的水平?” 他的回答是:“物理上可以制造出计算速度比人脑快一百万倍的大脑……如果人类思维因此加速,那么在外界每 31 秒的物理时间里,主观上就可以完成一年的思考,而一千年将在八个半小时内飞逝而过。” 尤德科夫斯基认为,如果我们现在不控制住局面,就为时已晚:“人工智能以与你不同的时间尺度运行;当你的神经元完成思考‘我应该做点什么’这句话时,你已经输了。”

范例是牛津大学哲学家尼克·博斯特罗姆在他的《超级智能》一书中提出的所谓的回形针最大化者的思想实验:一个人工智能被设计用来制造回形针,在耗尽其最初的原材料供应后,它会利用任何触手可及的原子,包括人类。正如他在 2003 年的一篇论文中描述的那样,从那里它“开始首先将整个地球,然后将越来越多的空间部分转变为回形针制造设施。” 不久之后,整个宇宙都由回形针和回形针制造者组成。

关于支持科学新闻业

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻业 订阅。 通过购买订阅,您正在帮助确保有关当今塑造我们世界的发现和想法的具有影响力的故事的未来。

我对此持怀疑态度。 首先,所有此类末日情景都涉及一系列的如果-那么的偶然事件,其中任何一点的失败都会否定末日。 西英格兰大学布里斯托尔电气工程教授艾伦·温菲尔德在 2014 年的一篇文章中这样说:“如果我们成功构建了人类等效的人工智能,如果该人工智能完全理解了它的工作原理,并且如果它随后成功地改进了自身以产生超智能人工智能,并且如果该超人工智能,意外地或恶意地,开始消耗资源,并且如果我们未能拔掉插头,那么,是的,我们很可能会遇到问题。 风险虽然并非不可能,但可能性不大。”

其次,人工智能的发展速度远低于预测,从而有时间在每个阶段构建检查机制。 正如谷歌执行董事长埃里克·施密特在回应马斯克和霍金时所说:“你不认为人类会注意到这种情况发生吗? 你不认为人类会然后去关闭这些计算机吗?” 谷歌自己的 DeepMind 已经开发出人工智能关闭开关的概念,有趣地描述为在人工智能接管尝试事件发生时要按下的“红色大按钮”。 正如百度副总裁吴恩达所说(在对马斯克的讽刺中),这“就像担心火星上的人口过剩,而我们甚至还没有踏上这颗星球一样。”

第三,人工智能末日情景通常基于自然智能和人工智能之间的错误类比。 正如哈佛大学实验心理学家史蒂芬·平克在他对 2015 年 Edge.org 年度问题“你如何看待会思考的机器?”的回答中阐明的那样:“人工智能反乌托邦将狭隘的阿尔法男性心理投射到智能的概念上。 他们假设超人智能机器人会发展出诸如废黜他们的主人或接管世界之类的目标。” 平克建议,同样有可能“人工智能将沿着女性路线自然发展:完全有能力解决问题,但没有消灭无辜者或统治文明的欲望。”

第四,计算机“想要”做某事(例如将世界变成回形针)的含义意味着人工智能有情感,但正如科学作家迈克尔·乔罗斯特指出,“一旦人工智能想要任何东西,它将生活在一个有奖励和惩罚的宇宙中——包括我们对它行为不端的惩罚。”

鉴于末日预测的历史成功率为零,再加上人工智能在过去几十年中逐步发展,我们有足够的时间来构建故障安全系统,以防止任何此类人工智能末日。