对普通人来说,人工智能领域似乎正在取得巨大进步。根据一些溢美之词的媒体报道和新闻稿,OpenAI 的 DALL-E 2 似乎可以根据任何文本创建壮观的图像;另一个名为 GPT-3 的 OpenAI 系统可以谈论几乎任何事情——甚至可以写关于它自己的文章;而 Alphabet 旗下部门 DeepMind 于 5 月发布的一个名为 Gato 的系统,据报道在公司可以抛给它的每项任务上都表现良好。DeepMind 的一位高级主管甚至吹嘘,在创造具有人类智能的灵活性和足智多谋性的人工智能(称为人工智能通用性,或 AGI)的竞赛中,“游戏已经结束了。”

不要被愚弄了。机器可能有一天会像人类一样聪明,甚至更聪明,但游戏远未结束。在制造真正能够理解和推理周围世界的机器方面,还有大量工作要做。我们现在需要的是少一些姿态,多一些基础研究。

人工智能正在取得进展——合成图像看起来越来越逼真,语音识别通常可以在嘈杂的环境中工作——但我们可能还需要几十年才能实现通用、人类水平的人工智能,它可以理解文章和视频的真正含义,或者应对意外的障碍和中断。该领域仍然受困于学术科学家(包括我自己)多年来一直指出的同样挑战:使人工智能可靠并使其能够应对异常情况。

关于支持科学新闻报道

如果您喜欢这篇文章,请考虑通过以下方式支持我们屡获殊荣的新闻报道 订阅。通过购买订阅,您正在帮助确保有关塑造我们当今世界的发现和想法的具有影响力的故事的未来。

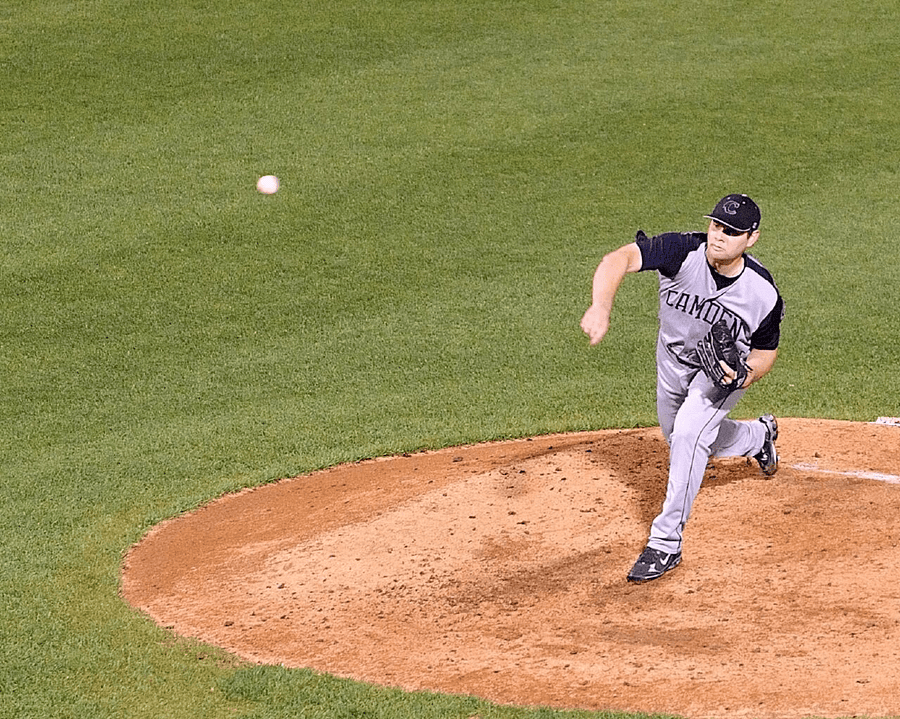

图片来源:Bluesguy from NY/Flickr (CC BY-ND 2.0)

以最近备受赞誉的Gato(据称是万事通)为例,以及它是如何为一位投手投掷棒球的图像(上方)添加标题的。该系统的首要三个猜测是

一位棒球运动员在棒球场上投球。 一个男人在棒球场上向投手投掷棒球。 一位击球手在击球,一位捕手在棒球比赛期间位于土堆中。

第一个回答是正确的,但其他两个答案包括了图像中没有的其他球员的幻觉。除了从与其他图像的统计相似性中得出的粗略近似值之外,该系统不知道图片中实际有什么。任何棒球迷都会认出这是一个刚刚投出球的投手,而不是相反。尽管我们预计附近会有捕手和击球手,但他们显然没有出现在图像中。

同样,DALL-E 2 无法区分红色立方体在蓝色立方体之上与蓝色立方体在红色立方体之上的图像。今年 5 月发布的较新系统,无法区分宇航员骑马和马骑宇航员。

当谷歌研究人员提示该公司的 AI Imagen 生成“宇航员骑马”的图像时,它反而呈现了宇航员骑马的图像。图片来源:Imagen

当像 DALL-E 2 这样的图像创建系统出错时,结果可能很有趣。但有时人工智能产生的错误会造成严重后果。一辆特斯拉自动驾驶汽车最近直接驶向一位在马路中间拿着停车标志的人工工人,只有当人类驾驶员介入时才减速。该系统可以识别单独的人类(这是他们在训练数据中出现的方式)和通常位置的停车标志(正如他们在训练图像中出现的那样),但在遇到两者不熟悉的组合时未能减速,这使得停车标志处于新的和不寻常的位置。

不幸的是,这些系统仍然无法可靠工作并且难以应对新情况的事实通常被埋没在细则中。例如,Gato 在 DeepMind 报告的所有任务上都表现良好,但很少像其他当代系统那样出色。GPT-3 经常创建流畅的散文,但在基本算术方面存在困难,并且对现实的把握非常薄弱,以至于容易产生诸如“一些专家认为,吃袜子的行为有助于大脑从冥想导致的意识改变状态中恢复过来”这样的句子。然而,粗略地看一下最近的头条新闻,你不会知道任何这些问题。

这里的副线剧情是,最大的人工智能研究团队不再出现在学术界(同行评审曾是学术界的通行货币),而是出现在公司中。与大学不同,公司没有公平竞争的动机。他们没有将他们引人注目的新论文提交给学术审查,而是采取了新闻稿发布的方式,引诱记者并绕过同行评审过程。我们只知道公司想让我们知道的事情。

在软件行业中,有一个词来形容这种策略:“演示软件”,即旨在在演示中看起来不错,但未必足够好用于现实世界的软件。通常,演示软件会变成“期货软件”,宣布出来是为了震慑和敬畏,以阻止竞争对手,但从未真正发布。

不过,报应终会来临。冷核聚变可能听起来很棒,但你仍然无法在商场买到它。人工智能可能会经历一段期望值降低的寒冬。太多的产品,例如无人驾驶汽车、自动化放射科医生和通用数字助理,已经过演示、宣传——但从未交付。目前,投资资金仍在基于承诺涌入(谁不喜欢无人驾驶汽车呢?)。但是,如果不可靠和无法应对异常值的核心问题得不到解决,投资将会枯竭。我们可能会在机器翻译以及语音和物体识别方面取得扎实的进展,但相对于所有过早的炒作而言,其他方面却乏善可陈。我们将不会得到“智能”城市和“民主化”的医疗保健,而是会留下破坏性的深度伪造和排放大量碳的耗能网络。

尽管深度学习提高了机器识别数据模式的能力,但它有三个主要缺陷。它学习的模式具有讽刺意味的是肤浅而非概念性的;它创建的结果难以解释;并且结果难以在其他过程(例如记忆和推理)的上下文中使用。正如哈佛大学计算机科学家莱斯·瓦利安特所指出的,“[未来的]中心挑战是统一...学习和推理的表述。” 如果你不真正理解停车标志是什么,你就无法处理一个人拿着停车标志的情况。

目前,我们陷入了“局部最小值”,公司追求的是基准而不是基础思想。当前的工程实践远远领先于科学技能:这些部门专注于利用他们已经拥有的、理解不充分的工具来勉强取得小幅改进,而不是开发具有更清晰理论基础的新技术。这就是为什么基础研究仍然至关重要。大部分人工智能研究界(例如那些高呼“游戏结束”的人)甚至没有看到这一点,这真是令人心碎。

想象一下,如果某个外星人仅通过观察地面上的阴影来研究所有人类互动,值得称赞的是,它注意到有些阴影比其他阴影更大,并且所有阴影在夜间都会消失。也许它甚至会注意到阴影在某些周期性间隔内有规律地增长和缩小——但从未抬头看到太阳或识别出上方的 3D 世界。

现在是人工智能研究人员从引人注目的、直接面向媒体的演示中抬起头来,询问关于如何构建能够同时学习和推理的系统的基本问题的时候了。